要想赚钱,AI模型该大该小?贾扬清:论AI模型经济学的技巧

HelloKitty • 2024-08-05 15:05

2568

本文由 AI科技评论 撰写/授权提供,转载请注明原出处。

文章来源于:AI科技评论

作者:刘洁

编辑:岑峰

最近的 AI 社区,关于模型规模的讨论有些活跃。

一方面,此前在大模型开发奉为“圣经”的Scaling Law,似乎正在褪去光环。去年大家还在猜测 GPT-5 的规模“可能会大到想不到”,现在这种讨论几乎绝迹。大神 Andrej Karpathy,则是在感慨大模型规模正在“倒退”。

另一方面,近期市场上性能优秀的小型模型层出不穷,参数规模、任务处理、反应速度、安全性能,各公司在不同方面卷了又卷。

究竟是往大做探索极限,还是往小做迎合市场?

这最终汇总成一个问题:在这样模型快速更迭的市场中,要怎么才能把 LLM 模型的商业价值最大化?

唯快不破的模型业态

最近发起讨论的是 X.ai 创始成员之一的 Toby Pohlen。他认为如果模型以指数级速度改进,那么训练模型的价值也会以指数级速度折旧。这也导致人们需要赶在模型更迭前就迅速采取行动获取商业价值,一旦模型产生更新,上一代模型就基本一文不值了。

Toby 的这番言论深得老板 Elon Musk 之心,大笔一挥打了一个“100 分”。

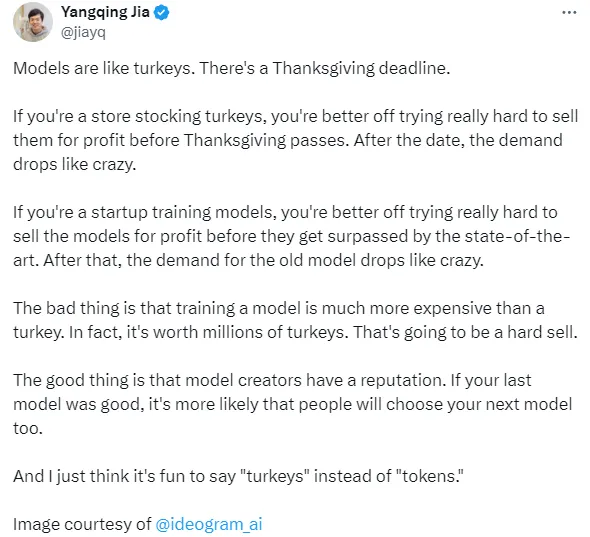

贾扬清也参与到了这场讨论中来,他用感恩节火鸡做了一个有趣的比喻。他提出,售卖模型就像是感恩节火鸡促销,必须在感恩节前夕抓紧时间售卖,避免在感恩节到来后的贬值。新模型的技术更新就是一个又一个感恩节,只有销售得更快才能赚到更多的利润。

(emmm...如果对火鸡不好了解,换成中秋节前抢月饼的故事大家或许应该容易理解一些?)

评论区也有不少人表达了对此观点的赞同。

有人说只要不断地开发新产品和迭代新模型,就能从中持续获得商业价值。

还有人说,模型改进的频率将直接决定模型本身的商业价值。

但是,模型的商业价值由什么决定,又该如何实现?

模型发展在走 CNN 老路吗?

模型必须做小,用起来才顺手。

比起大型模型,小型模型成本低应用便利,更能收获商业市场的青睐。贾扬清就发现,行业趋势在于研发和使用尺寸更小性能强大的模型,人们也更愿意把规模参数在 7B-70B 之间的中小型模型作为商业使用的选择。

作为前大模型时代的亲历者,贾扬清在当下LLM 模型市场上嗅到了熟悉的味道,先变大再变小变高效,这和 CNN 时期的模型发展简直一模一样。

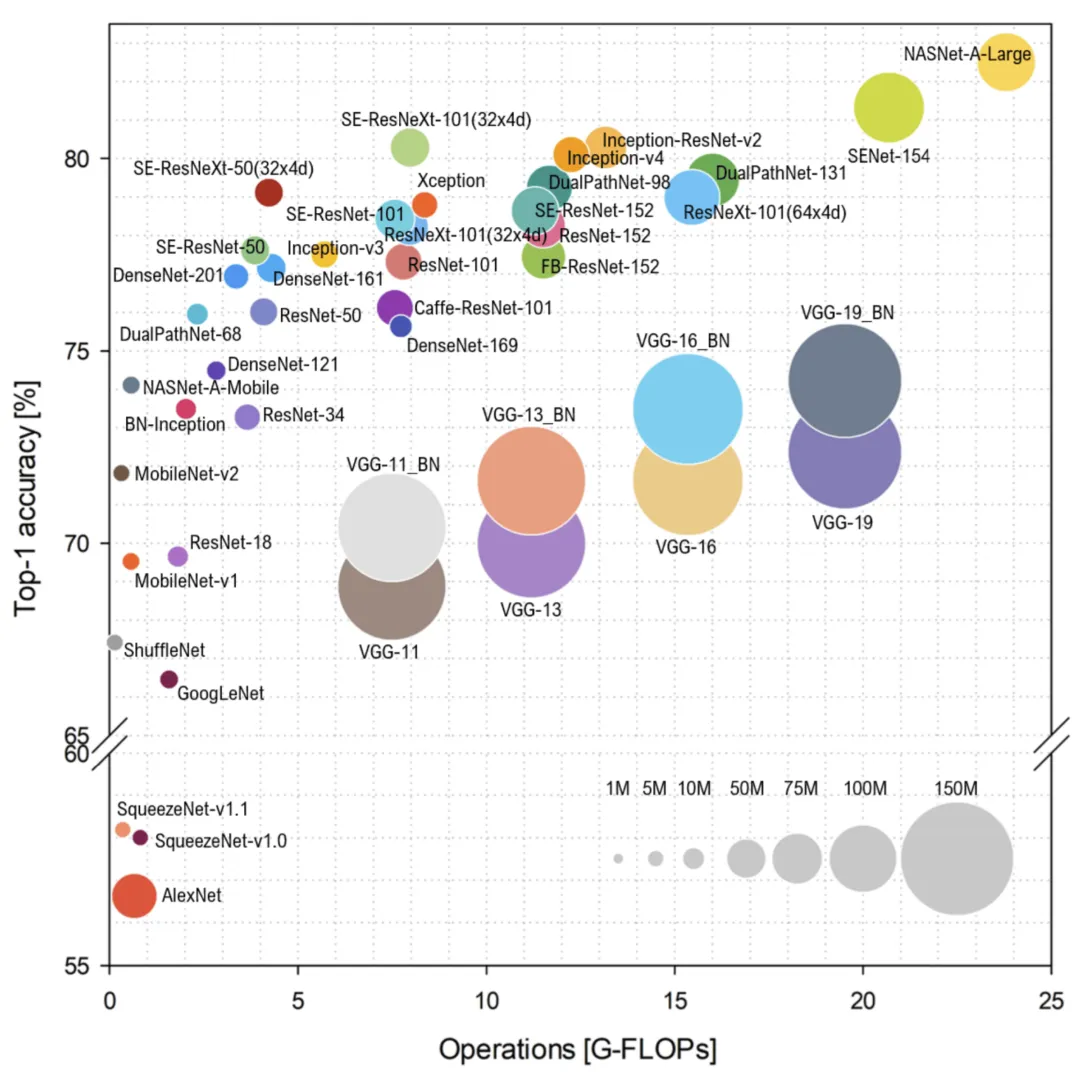

贾扬清还对 CNN 的发展历程做了一个简单的介绍。

首先是 2012 年,AlexNet 开启了模型大小增长的序幕。2014 年的 VGGNet 就是一个规模较大的高性能模型。 到了 2015 年,模型尺寸开始缩小。GoogleNet 将模型大小从 GB 降至 MB,缩小了 100 倍,还同时保持了良好的性能。同年面世的 SqueezeNet 也遵循了追求更小尺寸的趋势。 在此之后,模型发展的重点转移到了维持平衡。比如如 ResNet(2015)、ResNeXT(2016) 等模型都保持了一个适中的规模,注重计算效率。

贾扬清还介绍了 CNN 的一个有趣的应用,Google 的 MobileNet(2017),占用空间小性能优越,还具有出色的特征嵌入泛化。

最后,贾扬清引用了 Ghimire 等人在《高效卷积神经网络和硬件加速调查》里的一张图:

他还进一步发问,LLM 模型未来会遵循和 CNN 一样的发展趋势吗?

大型模型的盈利思考

不过贾扬清也补充道,虽然行业趋势是模型小型化,但并不意味着号召大家放弃尺寸更大的模型。

但这随之而来的是另一个问题:大型模型的成本会更高。

此前也有人提出质疑,对大型模型服务商的运营成本和营运收益做了简单的计算,每天 8 张 H100 显卡运营节点的成本约为 1000 美元,每天可以提供 2600 万 token 的服务,但按 Llama 405B 每一百万 token 3 美元的价格,怎么算都是亏本的,无法盈利的大型模型不会被市场抛弃吗?

贾扬清表示,哎你说这个我就不困了,我熟我来说:)

贾扬清认为,虽然每个请求大约每秒输出 30 个 token,但通过批量处理(同时处理多个请求)可以显著提高总吞吐量,可以达到比单个请求高出 10 倍或更高的吞吐量。

同时他还指出,每秒大约 30 个 token 指的是输出 token,大模型对于输入 token 的处理速度更快,这也增加了处理的总 token 数,大模型通常对输入和输出分别计费,也正是这个道理。

在后续的另一个回复,贾扬清做了更详细的量化计算:

批量输出速度:单并发 405b 推理通常有每秒 30 个 token 的输出速度。合理的并发可以使总吞吐量提高 10 倍,达到每秒 300 个 token 的输出吞吐量。 输入 token:输入 token 也被计费,通常输入 token 的数量远大于输出 token。一个常见的聊天机器人应用可能有 2048 个输入 token 和 128 个输出 token。假设输入输出 token 比率为 10:1,那么每秒 300 个输出 token 的处理量相当于每秒 3000 个输入 token。 价格:每天总共处理 285,120,000 个 token,按当前 Lepton 价格每百万 token2.8 美元计算,收入为 798.34 美元。 机器成本:以 lambda 按需价格为基准,每张 H100 卡每小时 3.49 美元,8 张 H100 卡一天的成本为 670.08 美元。

收入 798.34 美元,成本 670.08 美元,因此通过整合多种技术方法,在合理流量下(像 Lepton 这样的大模型技术服务商)是可能盈利的。

当然,这只是一个简单的推算,实际的盈利还会受到流量稳定性、计费方式、按需使用 GPU 的机器成本控制、解码、提示缓存以及其他因素的影响。

但某种程度上说,类似深度学习时代对 CNN 的不断优化,在大模型时代,也需要技术人员对于模型进行种种优化,来保证性能提高的同时不断降低成本,这正是贾扬清看好的创业路线。

One more thing

我们不妨再多讨论一下,对于贾扬清这样的 AI Infra 创业者,模型大小的潮流变化对他的商业模式有什么影响?

这个问题,要分不同情况分析。

如果模型参数量越大,提供模型服务的门槛越高(参考 Llama 405B),其客单价自然也就越大;

另一方面,由于很多小模型实际是在大模型的基础上蒸馏而得到,模型小了,所需的计算资源并没有等幅度减少;

由于较小的模型更容易部署在不同的设备和平台上,这可能会带来应用场景的增加,虽然客单价可能降低,但在需求数量上的增加反而可能使得总收入增加;

对于贾扬清来说,META 的开源路线使得贾扬清的服务对象扩大,因此开源对他来说更有利。

看来不管未来模型规模怎么不变化,贾扬清都有机会凭借技术升级稳坐钓鱼台。这有点像之前的中国股市,不管什么消息,都是“利好茅台”啊。

这恐怕就是贾扬清最近在推特上为什么这么活跃发表看法的原因?你看好贾扬清这种 AI Infra 的创业路线吗?

参考资料:

https://x.com/jiayq/status/1818902164938670206

https://x.com/TobyPhln/status/1818686287475282260

https://x.com/elonmusk/status/1818686692905435406

https://x.com/jiayq/status/1818703217263624385

https://x.com/jiayq/status/1818699120049311883

https://x.com/jiayq/status/1818704837745557912

https://x.com/jiayq/status/1817092427750269348

头图/封面来源于贾扬清X(https://x.com/jiayq/status/1818907312851169748)

扫码关注公众号

获取更多技术资讯