大模型「强崩溃」!Meta新作:合成数据有「剧毒」,1%即成LLM杀手

HelloKitty • 2024-10-14 16:54

4279

本文由 新智元 撰写/授权提供,转载请注明原出处。

本文来源:新智元

编辑:乔杨 桃子

1% 的合成数据,就让 LLM 完全崩溃了?

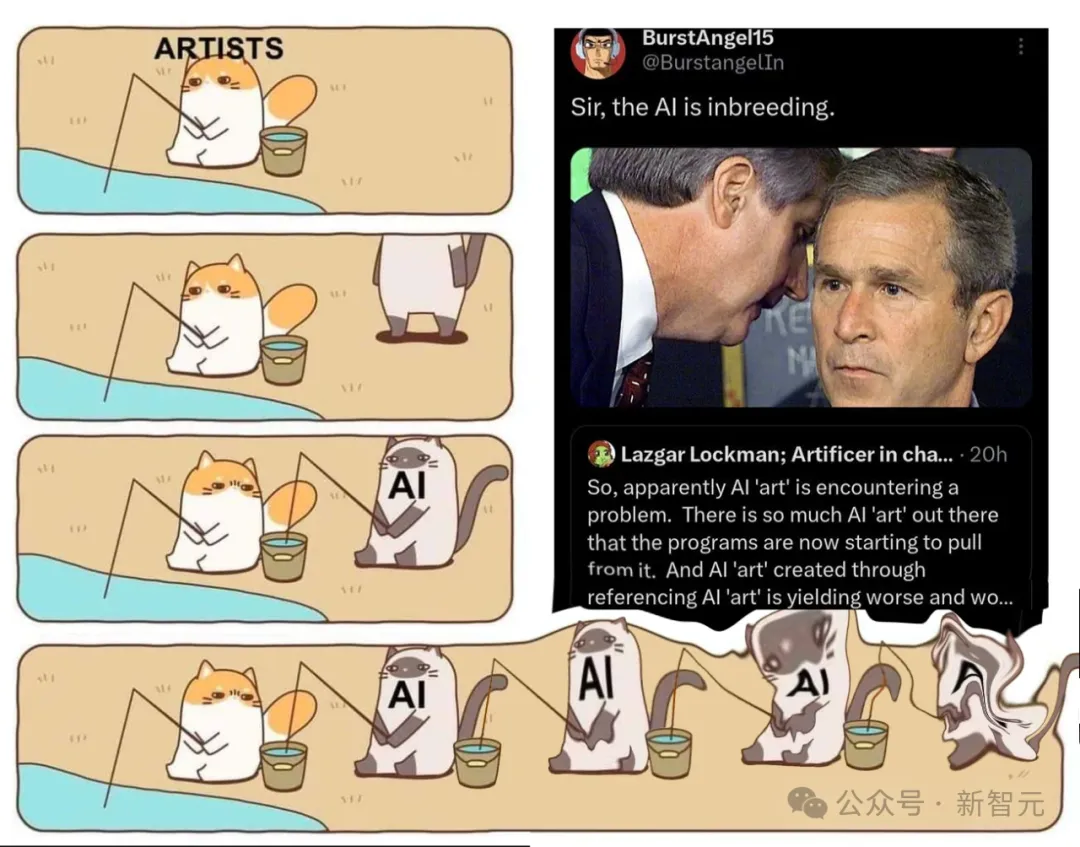

7 月,登上 Nature 封面一篇论文证实,用合成数据训练模型就相当于「近亲繁殖」,9 次迭代后就会让模型原地崩溃。

论文地址:https://www.nature.com/articles/s41586-024-07566-y

然而,许多大佬都不同意这篇文章的方法和结论。

比如,Scale AI 的 CEO Alexandr Wang 就很看好合成数据的前景,英伟达发布的开源模型Nemotron-4 340B 甚至使用了 98% 的合成数据。

最近,Meta、纽约大学、UCLA 机构发表的最新论文,再一次动摇了这些大佬们的结论。

论文地址:https://arxiv.org/abs/2410.04840

他们发现,即使合成数据仅仅占到总数据集的最小部分,甚至是 1% 的比例,仍然可能导致模型崩溃。

甚至,ChatGPT 和 Llama 这种较大的模型,还可能放大这种「崩溃」现象。

强模型崩溃,如何发生的?

随着越来越多的合成数据出现在训练集中,一种新的现象应运而生:「模型崩溃」。

所谓「模型崩溃」,是指随着时间的推移,LLM 或大型图像生成器在其前几代生成的数据上进行递归训练,导致性能下降,直至模型完全丧失能力的情况。

围绕着这个问题,AI 学界和业界的大佬依旧莫衷一是,尚未达成一致的结论。

而合成数据究竟会在多大比例、多大程度上导致「模型崩溃」,直接影响着我们在未来如何应用这项技术。

从直觉上理解,合成数据导致「模型崩溃」的底层逻辑,是由于模型开始对合成数据中的模式进行过拟合,而这些模式可能无法代表现实世界数据的丰富性或可变性。

如果进行连续的迭代训练,这种反馈循环会导致模型强化合成数据中存在的错误、偏差或过度简化,因而损害了对现实世界的准确表示能力和泛化能力。

总体而言,这篇文章旨在回答以下两个重要问题:

Q1:模型崩溃是不可避免的,还是可以通过策略性地混合真实数据和合成数据来解决?

Q2:较大的模型比较小的模型更容易崩溃吗?

针对这两个问题,论文以经典线性设置中的回归问题为例进行了理论分析,之后在「玩具设置」(MINIST 数据集+迷你模型)和更接近真实场景的 GPT-2 模型上运行了实验。

理论设置

数据分布

考虑从真实数据分布 P_1 采样得到的 n_1 个独立同分布样本

扫码关注公众号

获取更多技术资讯