击穿全网底价,通义千问GPT-4级大模型直降97%!1块钱能买200万tokens

HelloKitty • 2024-05-22 17:30

3123

本文由 量子位 撰写/授权提供,转载请注明原出处。

文章来源于:量子位(QbitAI)

作者:鱼羊

通义千问 GPT-4 级大模型,直接击穿全网底价!

就在刚刚,阿里突然放出大招,官宣 9 款通义大模型降价。

其中,性能对标 GPT-4 的主力模型 Qwen-Long,API 输入价格从 0.02 元/千 tokens 降至 0.0005 元/千 tokens,也就是 1 块钱能买 200 万 tokens,相当于5本《新华字典》的文字量,堪称全球大模型的性价比之王。

更直观一点对比——

Qwen-Long 支持 1000 万 tokens 的长文本输入,对比 GPT-4,价格仅为 1/400。

超大杯新品,此番也在降价名单中:刚发布不久的通义千问超大杯 Qwen-max,API 输入价格也直降 67%,低至 0.02 元/千 tokens。

开源方面,Qwen1.5-72B、Qwen1.5-110B 等 5 款开源模型的输入价格也分别直降 75% 以上。

这波操作,再次击穿全网最低价,可以说是专属大模型企业、程序员的 618 狂欢了。

1 块钱 200 万 token

来看具体降价情况:

本次降价,共覆盖 9 款通义千问系列模型,商业化模型、开源模型全都在列。

包括:

Qwen-Long,性能对标 GPT-4,API 输入价格从 0.02 元/千tokens 降至 0.0005 元/千 tokens,降幅 97%;API 输出价格从 0.02 元/千tokens 降至 0.002 元/千 tokens,降幅 90%。

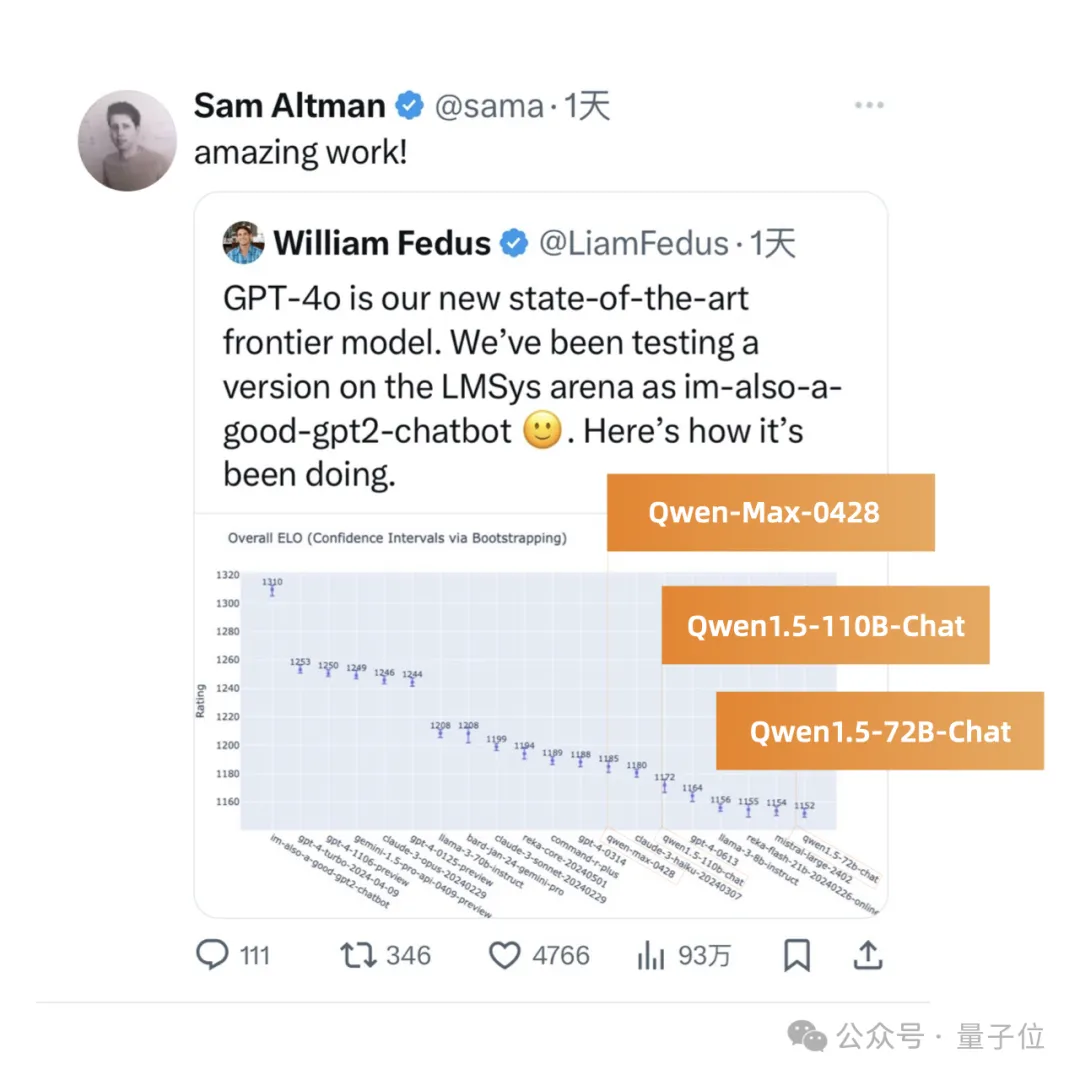

Qwen-max,在权威基准 OpenCompass上性能追平 GPT-4-turbo,API 输入价格从 0.12 /千 tokens 降至 0.04 元/千 tokens,降幅 67%。

上榜大模型竞技场排名的 Qwen1.5 系列开源模型方面,Qwen1.5-72B 的 API 输入价格从 0.02 元/千 tokens 降至 0.005 元/千 tokens,降幅 75%;API 输出价格从 0.02 元/千 tokens 降至 0.01 元/千 tokens,降幅 50%。

与 OpenAI 的 GPT 系列相比,降价后的通义千问系列,基本上都是 1 折购,性价比拉满。

以降幅最大的 Qwen-Long 为例,价格仅为 GPT-4 的 1/400,性能指标上却并不逊色。

尤其在长文本方面,Qwen-Long 支持最长 1000 万 tokens 的超长上下文对话,也就是能轻松处理约 1500 万字或 1.5 万页的文档。配合同步上线的文档服务,还可支持 word、pdf、Markdown、epub、mobi 等多种文档格式的解析和对话。

值得关注的是,不同于国内大部分厂商输入输出价格相同的定价方式,这次 Qwen-Long 的输入价格比输出价格降幅更大。

对此,阿里官方也给出了解释:

现在,用户结合长文本(论文、文档等)对大模型提问已经成为最常见的需求之一,所以模型输入调用量往往大于输出调用量。

根据统计,真实的模型输入调用量一般是输出的 8 倍左右。我们把用户使用量最大的输入 token 价格大幅降下去,对企业来说更划算,可以更好地做到普惠。

也是希望大家把长文本用起来。

阿里一出手就是大招

说起来,这已经不是阿里云第一次击穿行业底价。

就在今年的 2 月 29 日,阿里云刚刚整过一个云产品“疯狂星期四”的大活儿:全线云产品价格直降 20%,最高降幅达 55%。

属实是砍自己一大刀了。

如此大手笔,底气来源是阿里云作为国内第一大公有云厂商,在长期技术积累和规模效应下,已经构建起完备的 AI 基础设施和 Infra 技术优势。

而此番诚意满满的降价,背后更是显露出大模型应用时代,这种技术红利正在成为公有云厂商的“杀手锏”之一。

在 AI 基础设施层面,从芯片层到平台层,阿里云已经基于自研的异构芯片互联、高性能网络 HPN7.0、高性能存储 CPFS、人工智能平台 PAI 等核心技术和产品,构建起了高弹性的 AI 算力调度系统。

举个例子,PAI 支持 10 万卡量级的集群可扩展规模,超大规模训练线性拓展效率达 96%。在大模型训练任务中,达到同样效果可节省超 50% 算力资源,性能达到全球领先水平。

推理优化方面,阿里云主要提供了三大能力:

其一,高性能优化。包括系统级的推理优化技术,以及高性能算子、高效推理框架、编译优化的能力。

其二,自适应调优。随着 AI 应用的多样化,一个单一的模型很难在所有场景中都保持最佳效能,自适应推理技术允许模型根据输入数据的特性和计算环境的约束,动态调整推理技术应用和计算资源选型。

其三,可扩展部署。模型推理部署资源的扩展和弹性,能解决推理服务在一定时期内的潮汐现象。

此前,阿里云智能集团资深副总裁、公共云事业部总裁刘伟光也表示,公有云的技术红利和规模效应,会带来巨大的成本和性能优势。

这将促使“公有云+API 成为企业调用大模型的主流方式”。

大模型应用时代主流路线:公有云+API

这也正是阿里云把大模型“价格战”再度推向高潮的核心原因。

尤其对于中小企业、创业团队而言,公有云+API 一直以来被视作做大模型应用的性价比之选:

尽管开源模型发展势头迅猛,以 Llama 3 为代表的最强模型们更被认为已经有媲美 GPT-4 的表现,但私有化部署仍然面临着成本高昂的问题。

以使用 Qwen-72B 开源模型、每月 1 亿 token 用量为例,在阿里云百炼上直接调用 API,每月仅需 600 元,私有化部署成本则平均每月超 10000 元。

除此之外,公有云+API 模式还便于多模型调用,能提供企业级的数据安全保障。以阿里云为例,阿里云可以为企业提供专属 VPC 环境,做到计算隔离、存储隔离、网络隔离、数据加密。目前,阿里云已主导、深度参与 10 多项大模型安全相关国际国内技术标准的制定。

云厂商的开放性,还能为开发者提供更丰富的模型和工具链选择。比如,阿里云百炼平台在通义千问之外,还支持 Llama 系列、百川、ChatGLM 等上百款国内外大模型,同时提供大模型应用一站式开发环境,可以做到 5 分钟开发一款大模型应用、5 到 10 行代码即可搭建企业级 RAG 应用。

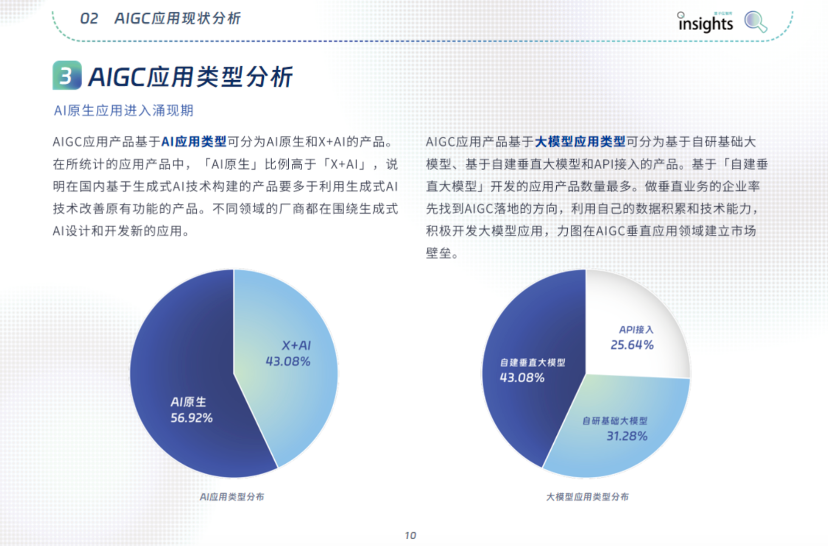

量子位智库在《中国 AIGC 应用全景报告》中提到,AIGC 应用产品中,基于自建垂直大模型和 API 接入的产品占到将近 7 成。

这一数据同样从侧面佐证了“公有云+API”模式的市场潜力:在应用市场,对业务的理解和数据积累才是破局关键,在公有云+API 的基础上做应用,在成本和启动速度方面都是更现实的选择。

实际上,无论是直观的价格之争,还是更深层次的 AI 基础设施之卷,反映出的都是,当大模型发展焦点逐步从基础模型迈向落地应用,平台厂商如何降低大模型的使用门槛,已经成为竞争的关键所在。

刘伟光指出:

作为中国第一大云计算公司,阿里云这次将主流大模型 API 输入价格降低 97%,就是希望加速 AI 应用的爆发。

我们预计未来大模型 API 的调用量会有成千上万倍的增长。

总结起来就是,一方面,对于平台厂商而言,“价格战”背后其实是基础设施、技术能力之争;另一方面,对于整个大模型行业而言,应用是否能持续爆发、进一步普及,入局门槛、运营成本已成关键因素。

如此看来,近来卷起的降价趋势,对于开发者和期待更多大模型应用的胖友们而言,不可谓不是利好消息。

你觉得呢?

*插播一条消息:在全球化的时代浪潮中,AI+跨境电商正迎来前所未有的发展机遇,为了让不同领域的企业聚集在一起,展示在AI跨境电商领域的服务和产品,促进行业内的信息流通和合作机会,白鲸跨境与白鲸技术栈正在招募一群富有激情和创造力的伙伴,共同绘制AI+跨境电商的生态图谱!如有感兴趣者,可点击下方链接进行报名。

AI+跨境电商图谱招募令报名链接:https://www.baijing.cn/activity/1636

扫码关注公众号

获取更多技术资讯