英伟达的挑战者Groq ,在LPU上押对了什么?

HelloKitty • 2024-03-12 17:48

3733

本文由 电厂 撰写/授权提供,转载请注明原出处。

文章来源于:电厂

作者:肖余林

编辑:高宇雷

在英伟达市值超过 2 万亿位居全球第三之后,谁能挑战它赖以生存的 GPU 芯片?

一款叫作 LPU 的 AI 推理芯片可能是这个答案。

在使用大模型的过程中,很多人会发现大模型回答问题时速度很慢,答案通常逐字或逐句跳出,并伴随着卡顿。但在 LPU 的加持下,大模型大幅提速,每秒能输出 500 个 tokens,远高于 ChatGPT 每秒 40 个的表现。而常用大模型都基于 GPU 加速,平均速度在每秒 20 个 tokens。

2 月 19 日以来,这款 LPU 持续成为热点,担当起英伟达 GPU 挑战者的角色。英伟达的主力芯片 H100 一卡难求,这给 Groq 公司带来了机会。

LPU 来自独角兽公司 Groq,这家公司成立于 2016 年,有一支明星研发团队。Groq 的团队来自谷歌,一手打造了谷歌的 TPU 芯片项目。英伟达曾经为了卖显卡发明了“GPU(图形处理单元)”这个词,Groq 专门发明了“LPU”,指的是“语言处理单元”,专门用于大语言模型推理任务。

Groq 表示,LPU 芯片速度比 H100 快 10 倍,成本仅为其十分之一,可以说把大模型的速度从“功能机”水平提高到了“智能机”水平,在英伟达最尴尬的时刻成功成为市场“新宠”。

被撬开的裂缝

围绕 Groq LPU 的讨论形成了两个方向。国外开发者借助 Groq LPU 开启了各式 DIY,来自不同应用的开发者发出同样的感叹:速度太快了!国内的技术社区则围绕 Groq LPU 的成本展开辩论,对 LPU 背后的技术来了一场深入解读。

Groq 给出数据,它的 LPU 能以十分之一的推理成本,提供 10 倍于英伟达 H100 的速度。

这一说法引起了质疑。AI 科学家贾扬清的计算数据显示,Groq LPU 虽然快,但每年的用电成本与 H100 相比多出了 10 倍。更多的讨论确认,Groq LPU 既没有运营成本的优势,也没有采购成本的优势。

原因很简单,Groq 指的“推理成本”主要用来衡量性能,它指的是“energy efficient”。业内描述成本,会使用直接与用电量挂钩的“power efficiency”。这意味着,LPU 对比 H100 测试的数据好看,但实际的参考价值不高。

此外,一个 Groq LPU 的内存容量是 230MB,一个 H100 的内存容量是 80GB。那么跑同样大小的大模型,需要更多数量的 Groq LPU。

Groq LPU 集群有惊人的算力,带来了非常高的吞吐量和容量,造成非常高的的耗电量的同时,表现在推理上就是我们看到的非常高的输出速度和非常低的延迟。

然后这并没有成为 Groq LPU 进入市场的障碍。

爆火之后,Groq 创始人乔纳森·罗斯(Jonathan Ross)在社交平台 X 上秀出芯片交货的照片,对外暗示,已经成功在 AI 芯片市场打开了局面。

几乎在一周内,Groq 组建了新部门 Groq Systems,专注于为客户和开发者构建生态;同时宣布收购初创公司 Definitive Intelligence,强化 GroqCloud 业务;紧接着联手沙特阿美,双方共同构建 GroqCloud 的推理功能。

此外,Groq LPU 不依赖三星或海力士的 HBM 以及台积电的 CoWoS 封装,供应链完全在北美,使用成熟的 14nm 工艺。可以说绕开了几乎所有造成主流芯片供应紧张的因素。而创始人罗斯则进一步表示,今年将部署 4.2 万个 LPU,争取通过合作扩大部署到 22 万个,到明年部署 150 万个。

似乎,英伟达主导的 AI 芯片市场被撬开了裂缝。

AI 专用芯片领域的创业公司不下百家,其中不少公司声称旗下的芯片比肩 H100,但很少有哪个产品经得起 Groq LPU 所经历的讨论。Groq 创始人乔纳森·罗斯对市场有自己的理解,他认为“没有人购买一件东西是因为这件东西更好,而是因为他们有未解决的问题。Groq 做的事情非常不同。”

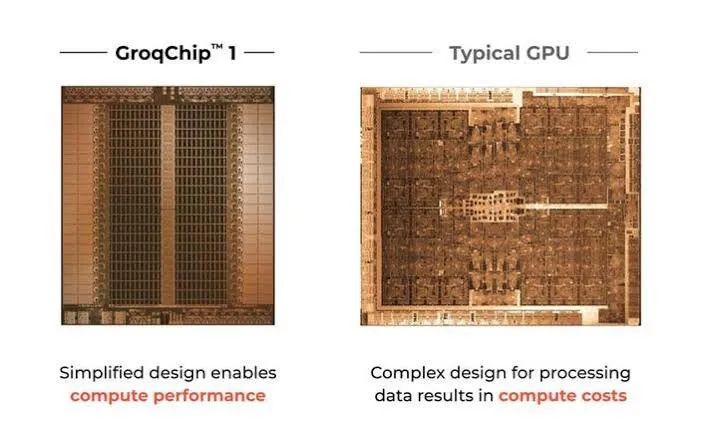

Groq LPU 设计与 CPU 或 GPU 形成鲜明对比,它所采取的“软件定义”的理念,在自动驾驶、网络、存储和其他硬件中正逐渐成为趋势。

专用芯片的确定性

经典的“软件吞噬世界”总结和预言了互联网的 .com 和 APP 时代,前特斯拉人工智能总监安德烈·卡帕斯(Andrej Karpathy)强调了“软件 2.0”的概念,也就是“软件吞噬世界,AI 吞噬软件”。

过去的软件是用 Python、C++ 等语言编写的,程序员能够解释其中的每一行代码,这代表了“软件 1.0”。安德烈·卡帕斯认为,“软件 2.0”指的是抽象的神经网络,程序员只能编写框架,几乎没有办法深入其中。与二进制文件或脚本相比,神经网络的矩阵乘法在许多计算配置上都可以运行起来。随着神经网络成为标准的商品,软件优先,软件定义硬件成为可能。

安德烈·卡帕斯基于这一理念帮助特斯拉推出了自动驾驶系统,并且从一开始就坚定地使用基于视觉的算法,不依赖激光雷达和高清地图。

今天,神经网络算法被用来解决科学、交通、安全等领域的各种问题,由于深度神经网络需要巨量的矩阵计算,是典型的计算密集型任务。大模型的爆发则进一步增加了计算规模和复杂性,给传统 CPU 和 GPU 架构带来了挑战。

CPU 和 GPU 的微架构不是为深度神经网络而设计,但它们固有的许多特性又使得其中指令执行的顺序和时序变得不确定且难以推理。比如在大语言模型当中,计算处理通常是串行的而不是并行的,如果没有第 N 个值,则无法预测第 N+1 个值。因此,采用并行设计的 GPU 不能在大语言模型中跑出完整的高性能。

Groq 表示正是“受到软件优先思维的启发”更新了芯片架构,针对串行任务优化,并消除了芯片中的无关电路。这种设计与 GPU 形成鲜明对比,GPU 就像一个大型的工作车间,工作人员穿行于不同环节处理工作。LPU 则提供了一条装配线,可以以顺序的、有组织的方式处理数据任务。

Groq 用了很长时间才有了这些思路,Groq 的风险投资人查马斯·帕里哈皮蒂亚(Chamath Palihapitiya)在一档播客中分享了 Groq 团队初创期间的失败经历。

Groq 曾在特斯拉早期考虑激光雷达方案时寻求合作,遭到了“善意拒绝”。后来团队考虑把技术卖给做高频交易的客户以及三信机构,都以失败告终。直到看到了英伟达的 CUDA,Groq 团队认识到必须构建一个高级编译器,从而能够适配各种模型。自成立以来,Groq 几乎用了一半的时间投入到编译器研发上。

Groq LPU 实现了软件定义硬件,芯片将管理权交给编译器,编译器负责调度和执行控制,承担了不确定性的任务,这保证了芯片硬件专注处理确定性的计算。这种方法从根本上绕过了传统的、以硬件为中心的架构模型的限制,成为了 Groq LPU 低延迟和高吞吐量的基础。

“软件定义”不是新鲜的概念,但这几年再次流行起来。比如,英特尔就在基辛格的带领下提出了“软件定义、芯片增强”战略。基辛格表示,软件间接定义了英特尔的代工战略以及工厂生产加速器芯片的能力。在智能驾驶领域,软件定义汽车几乎是所有玩家确定的方向。

Groq 把“软件定义”应用到芯片设计当中,也进一步拓展到芯片集群。Groq 表示,相比较其它云算力,经 Groq Cloud 加速的大模型速度可以提高18倍。

通用芯片的瓶颈

今天的大模型由 A100、H100 等通用 GPU 提供支撑,这些 GPU 能够提供庞大的 FLOPs 算力,满足大模型对训练数据的需要。然而,一旦到了训练之后的推理应用环节,通用 GPU 的瓶颈进一步被放大。

Transformer 为代表的自回归模型在推理过程中需要多轮重复计算,生成每一个 token,都会将所有输入过的 token 反复计算。那么,每生成一个 token,都需要与内存进行数据交互,这个过程称为“访存”。如果生成长序列的内容,访存的速度就决定了生成的速度。

即使对于 H100 这样的通用 GPU,在推理环节也面临访存速度的限制。财通证券在报告中提到,目前全球最先进 AI 芯片的计算速度“远快于”内存带宽。访存速度限制了推理速度,造成算力的利用率太低。

换句话说,大模型厂商和公司高价、排队买来的 H100,实际并不能物尽其用。更低的算力利用率等同于在增加芯片的采购成本。

业内普遍通过减枝、蒸馏、算子优化等方法提高利用率,这些方法又不可避免地影响了模型的质量。

英伟达 H200 芯片选择按部就班,搭载美光新一代 HBM3e 内存,峰值内存带宽大幅提升44%。

Groq 的方法是使用 SRAM 替换 HBM,借助 SRAM 自身优势,在单芯片上把内存带宽拉高到了 80TB/s,直接使推理速度得到了数量级提升。这一思路在 Graphcore、平头哥的产品上都出现过,Groq 做得比较彻底,它完全使用了 SRAM。

另外,Groq LPU 采用了 14nm 芯片工艺,2025 年推出的下一代将采用三星的 4nm,从而换来更多的计算矩阵和 SRAM。The Next Platform 预估,现在需要 576 个 LPU 才能完成 70B 大模型推理,到 2025 年可能只需要大约 100 个。

同时,Groq 将使用三星在北美的 4nm 工厂,最大限度地规避了供应瓶颈。这也是为什么 Groq LPU 仍然有市场。黄仁勋在财报电话会议上表示,AI芯片总体供应状况正在改善,但预计供不应求的状况仍将贯穿 2024 年全年。

Groq 风险投资人查马斯认为,今天的人工智能更多的是概念验证,或者是玩具应用程序,难以作为商业产品广泛交付给企业客户。原因很大程度上在于大模型效果不够好、速度太慢,需要太多的基础设施和成本。在向商业成果转化的过程中,LPU 适合各种规模的开发商,Groq 将有机会在商业化上实现飞跃。

Groq 把客户群体分为三类,大规模数据中心、全球 3000 强企业,以及其它所有人。查马斯透露,在 Groq LPU 爆火的短时间内,注册客户大部分来自规模公司。

Groq 高管在接受《The Futurum》采访时透露,他们相信全球 3000 强代表了 LPU 的重要市场。全球 3000 强开外的企业倾向于尝试 API 等基于云的产品。越来越多的企业告诉 Groq,他们希望独立拥有其专有数据,许多企业正在考虑增加本地数据中心,而不是仅与数据中心供应商合作。

扫码关注公众号

获取更多技术资讯