大模型时代,全球移动互联网公司APUS如何改写基因?

HelloKitty • 2023-04-26 17:47

2022

本文由 甲子光年 撰写/授权提供,转载请注明原出处。

文章来源于:甲子光年

作者:刘杨楠

编辑:栗子

4 月的 AI 领域可谓是“忽如一夜春风来”——阿里、华为、商汤等公司均发布自家大模型,钉钉、飞书、WPS 等产品也宣布接入大模型。

当初期的狂热褪去,不少人开始意识到,大模型不是低垂的果实,而是一场奔赴星辰大海的远征。然而,大模型究竟该怎么做,业内尚未形成共识。在所有人都“摸着石头过河”的情况下,比别人更快明确方向的人,往往会更接近成功。

麒麟合盛 APUS,这家曾经在移动互联网时代叱咤海外的工具出海企业,已经找到了答案。

4 月 18 日,APUS 发布了自研的多模态人工智能大模型“天燕大模型 AiLMe”。AiLMe 参数规模为 1000 亿,具备对文本、图像、视频、音频的理解和生成能力。

针对具体应用场景,APUS 从 AiLMe 内蒸馏出文本模型“异雀八”、图像模型“异雀三”、视频模型“异雀四”、音频模型“异雀六”四个垂直领域精炼模型,并基于此创新研发出“智能问答大师、简笔成画、墨染、Daily Astro、Star Night、KJV Bible Now、PicPik”等系列 AI 产品。

发布会现场,APUS 还发布了国内首份多模态大模型技术白皮书《AiLMe 技术白皮书》。

自 2014 年成立以来,APUS 聚焦工具类出海业务。今天的 APUS 早已实现营收正增长,月收入超过亿元,足迹遍及欧美、东亚、 东南亚、南亚、中东等 200 多个国家和地区,产品支持超过 25 种国际语言,累计全球覆盖用户超 24 亿。

如今,站在新世界的开端,APUS 正迎来一场蝶变。

新入场的大模型选手

4 月以来,国内大模型竞赛的激烈程度陡增。

目前,市面上已有多个团队推出了自研大模型,这些团队大致可分为四大类:

第一类,是百度、阿里、华为、腾讯等互联网大厂。大厂做大模型的优势有目共睹——他们有钱、有人、有算力,还有强大的规模效应。然而,大厂的劣势也十分突出。大厂往往会受庞大的组织架构和繁杂的业务体系所累,股东利益、市值波动、舆论影响都可能成为大厂的掣肘。

第二类,是王小川、王慧文等明星创业团队。这是资本和媒体最热衷追逐的团队,他们往往抱着义无反顾的决心,怀抱技术理想全力 all in。尽管如此,摆在创业团队面前的还有无数的现实问题——如何快速组建一支能打仗的队伍?如何保证源源不断的资金注入?如何快速确定技术与产品路径,尽量少走或不走弯路?

第三类,是来自清华、人大、复旦等高校的研究团队。相比大厂和创业公司,学术团队在资金、算力等硬资源的获取方面更为弱势。此前曾有业内人士表示,过往高校大多以小模型研究为主,很大一部分原因是受算力资源限制。此外,学术成果与产业落地之间的鸿沟也长久横亘在高校团队面前。

第四类,则是出门问问、APUS 这类已经拥有成熟的业务体系,但正在选择主动拥抱新趋势的“中型企业”。在这轮大模型竞赛中,目前能看到的这类玩家占比并不多。

在「甲子光年」看来,他们是此轮大模型竞赛中一股被低估的力量。无论出门问问还是 APUS,都已经有一套成熟的业务体系与稳定的营收来源,还拥有完整的技术与落地场景的积淀,但并未成长为巨头体量的庞然大物,对新趋势仍有很强的敏锐性与执行力。

在外界的印象中,APUS 身上的互联网基因更深刻。但事实上,APUS 创始人兼 CEO 李涛对人工智能有着深刻理解,他将中国人工智能的发展分为四步:

第一步:现有信息系统提效;

第二步:现有产品服务改造和重构;

第三步:诞生新场景、新物种;

第四步:全产业升级。

目前,APUS 已经在公司内部完成了第一步。APUS 所有内部信息化系统、效率分析、投产分析等环节均用人工智能完成。

在李涛看来,人工智能最大的机会在于第二步——现有产品服务的改造和重构。这也正是 APUS 瞄准的机会。

如今,人工智能已经能够协助人类设计首饰、创作网文、调试代码程序......毋庸置疑,传统IT产业与移动互联网产业是最先受到大模型冲击的行业,同时也是最容易捕捉到机会的地方。

可以预料,未来人工智能还会在更多未知场景激发想象,催生此前从未有过的新物种和新场景。但此时此刻,没人知道新物种和新场景究竟会是什么。

作为在移动互联网产业浸淫近十年的工具出海企业,APUS 已然立于新时代的潮头。“今天我们所焦虑的是我们必须在当前的时间窗口跑步上车,还要站在车头。只有这样,我们才有捕捉新物种的机会。”李涛说。

当前三步就绪,人工智能将会催化全产业升级。农业、传统工业等产业数字化的“死角”,都将因人工智能技术的进步而迎来全新的春天。

在理顺人工智能的演化趋势后,李涛便带领 APUS 自 2018 年起开始布局人工智能,并推出了多款基于 AI 技术的应用,如 CutCut、PickU 、Vieka 等,用户可以体验智能抠图,变老变年轻等功能。

此次发布 AiLMe,更像是 APUS 从“移动互联网出海企业“转型为“全球化 AI 企业"的一次正式宣言。

跳出大参数与大算力的“暴力怪圈”

目前,国内是否“该做”大模型的问题已经有了共识,但大模型具体要“怎么做”,各家都在摸着石头过河。

OpenAI 已经用 GPT 系列模型验证了基于大算力的暴力美学,但在很多从业者看来,一味加大模型参数并非最优路径。

2 月 25 日,Meta 发布 LLaMA 模型,给业界提供了另一种思路。

LLaMA 模型有 70 亿、130 亿、330 亿和 650 亿四种参数规模,训练语言高达 20 种。在对比测试中,LLaMA 模型在仅 130 亿参数规模上,就已经可以“在大多数基准上”胜过参数量高达 1750 亿的 GPT-3,且能在单块 V100GPU 上运行;而其 650 亿参数的模型已经可以媲美 ChatGPT。

在数据方面,LLaMA 仅使用公开数据集训练,包括开放数据平台 Common Crawl、英文文档数据集 C4、代码平台 GitHub、维基百科、论文预印本平台 ArXiv 等——这有助于后续的开源兼容和可复现。

整个训练数据集在 token 化之后大约包含 1.4T(1.4 万亿)个 token。其中,LLaMA-65B 和 LLaMA-33B 是在 1.4 万亿个 token 上训练的,而最小的模型 LLaMA-7B 是在 1 万亿个 token 上训练的。

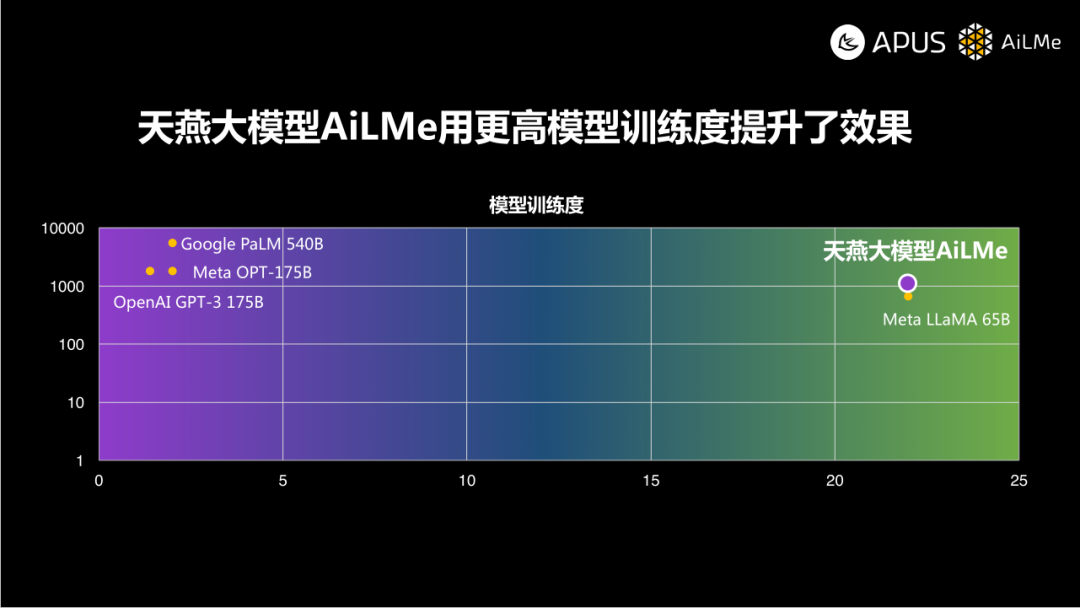

LLaMA 的出现,验证了 GPT 之外的另一条路径——更大规模的训练数据+更优的算法调试能够降低模型对参数和算力的依赖。

事实上,在 LLaMA 之前,已经有人验证了这一路径背后的规律。

2022 年 3 月,来自 DeepMind 的 Jordan Hoffmann 等人在论文《Training Compute-Optimal Large Language Models》中提出 Hoffmann 定律:用 20 倍于模型参数规模的训练数据来训练大模型,效果最好。而 LLaMA 模型的训练数据量约为参数规模的 22 倍。

2023 年 3 月以来,开源社区通过 Fine-tuning 的方式验证,如果用高质量的数据进一步精调 Meta LLaMA,还可以用更小规模参数接近 GPT-3 甚至 GPT-4 的效果。基于此,APUS 在《AiLMe 技术白皮书》中指出,对于大模型的效果而言,高质量的训练数据是第一位的;其次是更多的训练数据;最后才是参数的规模。

这种不依赖大算力的路径与李涛对大模型的认知不谋而合。“凡是用算力解决的都是暴力方法,还是你的算法不够聪明。”李涛分享道。

李涛将大模型核心要素分为四类——场景、数据、算法、算力。其中,看似最难的算力是一个“纸老虎”,算法才是目前更具挑战的事。“算法是最有挑战的一件事,也是我们整个中国开发团队值得做的一件事”。只要把算法提高,算力依赖度会大幅降低。”李涛说。

基于以上前提,李涛提出中国要在人工智能领域快速追上世界领先水平,需要双向进化——一方面从 1 到 10,从 10 到 100,搭建模型层之上的生态;另一方面从 1 到 0,反向补足算力的缺陷。

而 APUS 做的正是从 1 到 100,乃至 1000 的事。

确定大方向后,APUS 为天燕大模型 AiLMe 选定了两大技术环节——底层的多模态大模型采用 AI 训练 AI 的方式,并在底层大模型之上进行知识蒸馏,形成文本、图像、视频、音频四大垂直领域的精炼模型。

就模型训练过程而言,天燕大模型 AiLMe 分为预训练(Pre-trained)和微调(Fine-tuning)两大阶段。在微调阶段,天燕大模型训练时采用了“AI 训练 AI”的方式,训练所需的数据,是用其它高质量 AI 回答的结果来生成的,从而提高训练数据的质量。

算力方面,APUS 在国内郑州和新加坡分别建设了两大智算中心,还融合自建 GPU 服务器算力和第三方的算力协同作用。

数据方面,AiLMe 的训练数据主要有四大来源:

. 互联网公开的语料库,例如开源语料库(内含维基百科、人类图书库、Github 代码库、论文库、图像库等)、图像训练集、国家语委现代汉语语料库、北京大学汉语语料库等;

. 从互联网抓取公开网页内容(通过爬取的方式清洗标记以后进到统一的语料库中);

. APUS 创办以来的产品和服务所沉淀下来的场景数据;

. 行业公开数据。

值得注意的是,天燕大模型 AiLMe 的参数为 1000 亿,训练的充分程度已经和 Meta 的 LLaMA 相近,训练数据量约为参数规模的 22 倍。在这些数据中,有相当部分为 APUS 此前的用户数据沉淀。

在天燕大模型 AiLMe 之上,APUS 还针对文本、图像、视频、音频四大具体场景蒸馏出了相应的精炼模型,分别为异雀八、异雀三、异雀四、异雀六。

APUS 技术专家张旭表示,直接为 APUS 产品提供服务的主要是蒸馏出的精炼模型,即无论调用 API 还是直接使用 APP,背后对应的均为蒸馏模型。

换句话说,基于垂直场景的精炼模型直接担负起了 APUS AI 能力的商业化重任。

此外,APUS 还涉及了一套“插件式”架构,这套架构可以自主学习和使用“工具”,这些“工具”以插件的方式接入到 AiLMe 的平台中,模型能够自主判断某个任务是否需要调动插件。如果模型无法直接处理,便会调用插件库的插件完成任务,而调用插件的结果也会被 APUS 沉淀为后续模型迭代改进的基础。“生成”部分则沿用了目前业内主流的扩散模型(Diffusion Model),并继承了开源社区的生态。

用 C 端的长处,拉动 B 端的建设

不难发现,目前国内发力大模型的厂商多会选择“两条腿走路”,在开发大模型的同时,寻找落地应用场景。

在具体实施路径上,大多数厂商选择先推出 C 端产品以收集数据,进一步迭代模型,之后再开放 API,建立生态。APUS 也不例外。

不同在于,对于很多大模型厂商而言,这种“两条腿走路”的路径在一定程度上是被动“试错”。在《2023 年 AIGC 应用与实践展望报告》中,甲子光年智库指出,目前是 AIGC 企业发展的最初阶段,企业在探索中寻找合适的场景进行商业化落地,往往跨越技术栈的多个层级实现商业试错。

但 APUS 的选择,则有更多主动性。

对于 APUS 而言,首先发力 C 端是一个更自然的选择。作为移动互联网时期工具出海的头部企业,APUS 在海外积累了大量用户。成立八年来,APUS“足迹”遍及欧美、东亚、 东南亚、南亚、中东等 200 多个国家和地区,产品支持超过 25 种国际语言,累计覆盖全球 20 多亿用户。

多年的工具出海经验,让 APUS 更知道 C 端用户需要什么。

“APUS 做的事,就是用我们在 C 端的长处,拉动我们 B 端的建设,我们要给所有开发者做出样板,这也是我们为什么会在今天把产品发布出去的原因。用户总是会有各种各样的奇思妙想,我们会根据用户场景下的奇思妙想产生的数据再次进行模型训练,这是非常重要的一件事。”李涛表示。

在很多人看来,场景只是积累数据的来源,但这实则是对场景本身的忽视。李涛认为,数据是数据,场景是场景。

李涛用一个直观的例子解释了自己为何如此重视场景的力量:“几周前我听说一个创业团队用人工智能帮人设计首饰,我尝试了一下,结果设计的戒指丑到你无法接受,就是一个疙瘩。看到这个结果后,开发者自然知道应该把模型向什么方向调整,这个场景绝对不是工程师在实验室里能想到的。”

场景是用户真实的际遇,要把场景捕捉到,创业公司才能比巨头更快确定方向。这也正是 APUS 此次随基础大模型连推7款产品的原因。

目前,AiLMe 已在多个 to C 场景落地。

基于 AiLMe 大模型蒸馏出的异雀(八、三、四、六)系列精细模型,APUS 分别在文、图、视、音四个垂直领域,创新研发了多款人工智能产品:

. KJV Bible Now 是一款面向海外市场的《圣经》产品,让用户拥有自己的专属牧师助手,帮助其解答用户困惑,释放情感。

. PicPik,是一款 AI 图片、视频、娱乐创作工具,能够帮助用户高质量、高效率、低门槛的创作。

. Daily Astro 是一款面向海外市场的款塔罗牌产品,让星座、占卜爱好者实现牌面占卜、运势解析。

. Star Night 是一款助眠类产品,除了能为用户提供白噪音音频等帮助用户快速入睡,还能依据用户喜好勾勒出理想的数字睡眠伴侣,让它来朗读睡眠故事。

. 智能问答大师能够在对话之间帮助用户快速完成撰写报告、论文、程序、简历及解答生活疑问等。

. 简笔成画则让用户变身“神笔马良”,只要在手机屏幕上画出草图,寥寥几笔,它就会自动补全图案,形成精美绘画。

. 墨染作为 AI 绘画工具素材创作社区,功能丰富,除了有慕夏、毕加索等30多款创作风格可选,还具备文案优化等功能。

据悉,AiLMe 将会向客户开放 API 接口和服务。届时,客户可根据实际应用需求,调用 AiLMe 的各项 AI 技术能力。

卡位底层大模型厂商

这场大模型之争背后,实则是一场生态重塑。“只有技术,但没有能力建立起生态,整个模型还是不 work 的。”李涛表示。

涉及到生态问题,便绕不开开源与闭源的路线之争。

事实上,开源与闭源并无好坏优劣之分,这更多是创业者基于自身站位的选择。例如今天去看苹果和安卓的竞争,很难明确区分究竟谁胜谁负。大体来看,开源胜在生态丰富,而闭源胜在商业成功。

但如果将时间拉得足够长,借用 OpenAI 创始人 CEO

Sam

Altman 提出的“万物摩尔定律”——未来在 AI 时代,社会成本主要有两大构成,一个是 AI 的获取成本,一个是能源的获取成本。这两大成本会急剧降低,当它们趋近于 0 的时候,社会中的商业化就不再是一个难题,因为“商业化”这个概念可能会产生根本性改变,或者消失。

从这个意义上出发,开源,或许会是操作系统生态的终极理想状态。

李涛是“开源”路线的忠实拥趸。在他看来,开源也是让国内企业更快追赶大模型的有效路径。“一定要用 AI 开源,只有这样才能让我们大模型研发的效率最高,否则根本来不及(追赶国外)。”李涛表示。

早些时候,李涛也曾在访谈中表示:

所有代码都开放出来意味着有更多人能够维护和优化代码,代码一旦升级到很高的水平,数据和模型能力就会迅速提升,这本质上是一个利己的行为。OpenAI 就很聪明,它做完这件事就把接口全部开放出来了。而且也更利于训练自己的模型,模型训练需要更多的数据和场景,这不是千百个程序员坐在办公室能想出来的。从另一个角度来看,公开算法会促使更多开发者进行创新,能够推动行业进步,也是在创造更好的创新环境和发展氛围。这样看来,开源利人利己,何乐而不为?

在开源生态中,来自开发者的共建无疑是生态中不可或缺的组成部分,但是整个开源生态能够繁荣生长的基础,是一个足够包罗万象的技术底座。

在《2023 中国 AIGC 市场研究报告:ChatGPT 的技术演进、变革风向与投资机会分析》中,甲子光年智库认为,AIGC 将形成类似云计算的生态结构:只有底层足够“包罗万象”,才能支撑前端足够的“奇形怪状”。

从生态角度看 APUS 的技术路线,便会发现,APUS 实则是以开源模型算法为基础,加上海量高质量数据,形成了更能够“包罗万象”的基础模型 AiLMe。通过知识蒸馏获取精炼模型后,AiLMe 便能够真正意义上支撑应用层形形色色的场景需求。

可以看到,“底层大模型厂商”是 APUS 在这轮大模型竞赛中的自我定位,但“成为大模型生态的构建者”,才是 APUS 真正的野心。

选择比盲目努力更加重要

此时此刻,“竞争”是大模型创业热潮下一个绕不开的话题。

对于当前轰轰烈烈的大模型创业热潮,李涛表示“这是一件好事”。毕竟,互联网已经太久没有新鲜事了。Web3.0、加密货币、元宇宙等风口盛极一时,却始终无法让创业者真正找到可行路径。但大模型的不同在于,这是一条已经被验证的,且有真实产品成果的技术路径。

然而,创业者也需要面对更为残酷的现实——大模型创业对资金门槛要求极高。据李涛透露,APUS 目前训练大模型的投入已经达到 1000 万美元,更不用说王慧文和王小川均准备了 5000 万美元的启动资金作为入场券。

当然,充沛的资金供给只是开启大模型事业的万里长征第一步。“大模型不是你花钱多就能搞定所有事情,最有价值的地方是技术路线的选择。”李涛表示。

在李涛看来,大模型是一个类似操作系统的机会,短期内一定会出现很多模型,但最终会收敛到少数几家,拼的还是效率、ROI\ROE 以及最终的商业化成果。

对创业团队而言,互联网巨头是一个强有力的竞争者。但李涛认为,大模型不是巨头的游戏。大模型还处于“公元前”,技术路线不明确,会迎来一个“百花齐放”的时期,大公司很难 all in。李涛进一步表示,创业公司要与大厂竞争,就是要更快选择自己的技术路径。“为什么我要发布技术路线图?因为我没得选,我只能选一条路把它打下来。”

除了“更快”,还要“更准”,创业者要比大厂更懂用户的需求,而让用户尽快使用到产品,收集用户数据是最直接有效的“市场调研”。模型的训练大多是基于互联网上的公开语料库,而产品数据能让开发者看到用户真实的使用场景。

目前,APUS 对大模型浪潮的拥抱已经嵌入到每一位员工的日常。今年以来,APUS 便在公司实行全新的激励机制,要求所有程序员、设计师以及生产一线的同事都必须用人工智能来提升自己的生产效率,提升 30% 效率的加薪 10%,如果提升 50% 以上加薪 20%-30%。

李涛告诉 APUS 所有员工:“假如有一天你从 APUS 辞职,因为你多了这项能力,你在另外一家公司的薪水也会高很多,比别人更有竞争力。人工智能淘汰很多基础工作的过程是不可逆的,我们只能去拥抱,没有别的办法。”

人类对 AGI 的探索还远未看到尽头,如今只是万里长征第一步,没人能预料到谁会是最后赢家。关于未来,作为 APUS 创始人的李涛有一个看起来十分朴素,却又难掩雄心的心愿:

“让所有开发者都用上 AiLMe 的 API,这是我的期待。"

扫码关注公众号

获取更多技术资讯