追平多模态满血o1,kimi的新模型k1.5 破解了OpenAI的秘密?

HelloKitty • 2025-01-24 10:32

5954

本文由 硅星人Pro 撰写/授权提供,转载请注明原出处。

文章来源于:硅星人Pro

作者:周一笑

年关将至,大模型行业又热闹了起来。一天之内,两个“对标”o1 的国产大模型相继发布,分别是 DeepSeek 的 DeepSeek R1,以及 Kimi 的 k1.5。

先是 DeepSeek 发布了性能比肩 OpenAI o1 正式版的 R1,同时还公布了详尽的技术报告,并继续开源模型权重,这再次让海外技术社区感叹,“DeepSeek 才配叫做 OpenAI”。

几乎同一时间,Kimi 发布了全新的强化学习模型 k1.5,OpenAI 之后首个多模态类 o1 模型。

去年 11 月,Kimi 推出了 k0-math 数学模型,12 月发布了 k1 视觉思考模型,这次是 k 系列模型的第三次升级,延续了快速持续改进的节奏。

考虑到 OpenAI o1 预览版的发布时间是去年 9 月,o1 完整版发布到现在不到两个月,且 OpenAI 没有披露具体技术的情况下,海内外大模型的“技术代差”似乎越来越小了。

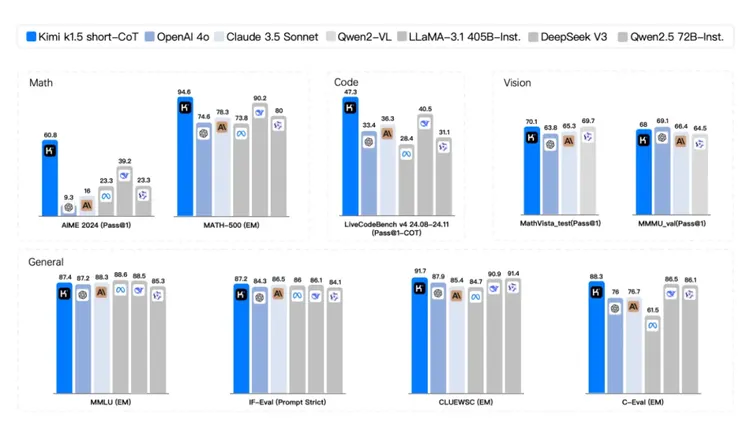

具体来看,在涵盖了数学、代码和视觉的基准测试上,k1.5 的 long-CoT 模式(长推理)表现与 OpenAI o1 非常接近,在某些测试中甚至略有超越。

在 short-CoT 模式下(短推理),k1.5 在数学、代码、视觉、通用能力的测试项目中领先于其他模型,包括 OpenAI 4o 和 Claude 3.5 Sonnet。

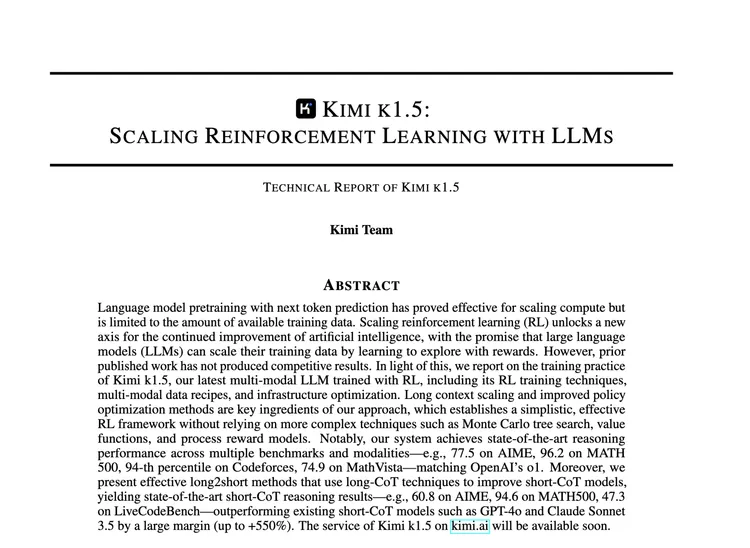

虽然没有开源模型,但在 k1.5 的发布中,Kimi 团队首次公开了 25 页的模型训练技术报告《Kimi k1.5: Scaling Reinforcement Learning with Large Language Models》,特别是在强化学习这样的前沿领域,技术报告本身就具有重要的研究价值。

藏在技术报告中的“黑科技”

Kimi k1.5 模型的设计和训练有几个关键要素,核心是利用强化学习(RL)来增强其推理能力:

强化学习 (RL) 是关键:与大多数模型仅从静态数据中学习不同,Kimi k1.5 使用 RL 通过试错学习,并在奖励的指导下进行。

长上下文扩展:一个主要组成部分是处理非常长的文本序列的能力,最多可达 128,000 个 token。这是通过在训练期间使用部分展开(partial rollouts)来实现的。这意味着系统重复使用先前尝试的部分内容,而不是从头开始重新生成整个新的训练序列,从而提高训练效率。这种长上下文允许模型更详细地“思考”复杂问题,类似于规划、反思和纠正其推理过程。上下文窗口的长度通常被认为是使用 RL 和 LLM 时持续改进的关键维度。

改进的策略优化:RL 过程使用在线镜像下降(online mirror descent)的变体进行微调。这种方法有助于模型在其解决问题的过程中做出更好的决策。这种优化通过更好的采样策略、长度惩罚和优化的数据配方得到增强。

简洁的框架:长上下文和改进的策略优化的结合,为使用 LLM 学习建立了一个简单而有效的框架。该系统不需要诸如蒙特卡洛树搜索、价值函数或过程奖励模型等复杂技术。

多模态:该模型使用文本和图像数据进行联合训练,使其能够利用这两种类型的信息进行推理。

Long-CoT 到 Short-CoT 的迁移:该模型可以利用其长上下文推理能力来改进短推理模型。这可以通过使用长 CoT 激活的长度惩罚和模型合并等技术来实现。

RL 数据收集

Kimi k1.5 的 RL 数据收集特点在于其高质量和多样性,以及为了训练效率所做的优化。为了确保训练的有效性,数据需要涵盖广泛的学科(如 STEM、代码和一般推理),并具有均衡的难度分布。为了避免模型作弊和过拟合,会排除容易被猜测答案的问题,并使用模型自身来评估问题难度。为了提升效率,还会利用课程学习和优先采样等策略,以及局部展开的技术来处理长序列。针对代码问题,还会自动生成测试用例,针对数学问题会使用链式思考的奖励模型以提高评分准确性,并且视觉强化学习数据也分为现实世界、合成和文本渲染三种类型。

Long2short

Kimi k1.5 模型使用了多种 long2short(长转短)方法,通过从 long-CoT 模型转移知识来提升短思考 short-CoT 模型的性能。虽然长思考模型能够达到很好的性能,但在测试时会消耗更多的 tokens。几个关键的 long2short 学习方法包括:

模型合并(Model Merging):这种方法通过对长思考模型和较短模型的权重取平均值来组合它们,在不需要额外训练的情况下得到一个新模型。

最短答案筛选(Shortest Rejection Sampling):这种方法对同一个问题进行多次采样,选择最短的正确回答用于监督式微调。

DPO (直接偏好优化) (Direct Preference Optimization):让 CoT 模型生成多个回答样本,选择最短的正确解决方案作为正样本,而将较长的回答作为负样本。这些正负样本对构成了用于 DPO 训练的成对偏好数据。

Long2short RL:在标准强化学习训练阶段后,选择在性能和 token 效率之间取得最佳平衡的模型作为基础模型。然后进行单独的长转短强化学习训练阶段,应用长度惩罚并减少最大展开长度,以进一步惩罚超过期望长度的回答。

在AIME2024测试集上k1.5整体表现出更好的token效率

这些方法有助于提高短思考模型的 token 效率,同时不牺牲性能。通过转移长思考模型的思维模式,短思考模型可以用更少的 token 预算达到更好的结果。与其他方法(如 DPO 和模型合并)相比,Long2short RL 展现出最高的 token 效率,而 k1.5 系列模型总体上显示出比其他模型更优的 token 效率。

总的来说,long2short 方法帮助短 CoT 模型从长 CoT 模型的推理策略中学习,用更少的 token 实现更好的性能。Kimi k1.5 的报告显示,这可以带来性能提升,例如在 AIME 2024 和 MATH 500 基准测试上的表现。Kimi 团队认为这是一个重要的研究方向,可以进一步提高语言模型的效率。

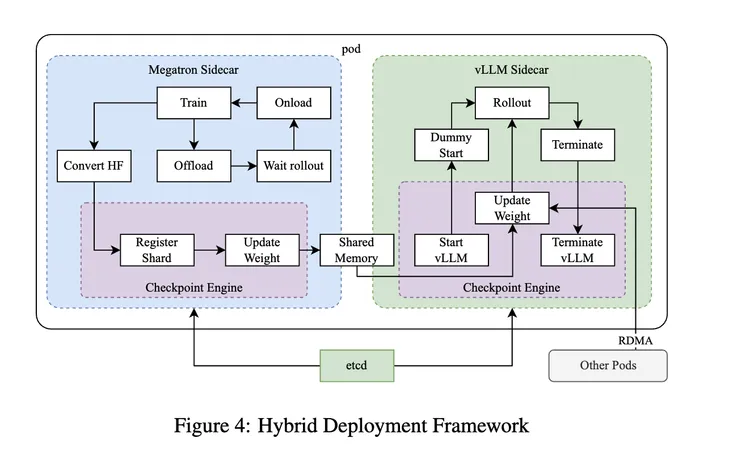

Infra 的混合部署框架

Kimi k1.5 系统引入了多项基础架构创新以支持 llm 的高效强化学习训练。其核心是混合部署框架,它允许在同一个 Kubernetes pod 的 GPU 上同时部署训练和推理工作负载,通过使用独立的 Megatron(用于训练)和vLLM(用于推理)容器,并由检查点引擎管理生命周期,有效防止了训练节点在等待推理节点时的闲置状态。

系统还采用了部分展开技术来高效处理长上下文 RL 训练,它通过将长回答分割成多个迭代段并从重放缓冲区重用之前的片段来减少计算开销,同时包含重复检测功能以及早识别和终止重复序列。

在代码执行方面,系统配备了专门的沙箱服务,使用 crun 代替 Docker 作为容器运行时并重用 cgroups,以提供安全高效的代码执行环境。

此外,系统还包含了由 etcd 服务管理的全局元数据系统用于广播操作和状态,以及使用 Mooncake 通过 RDMA 在对等节点之间传输检查点。这些创新组件共同构建了一个高效的训练系统框架,使 Kimi k1.5 模型能够有效应对长上下文和多模态数据训练的挑战。

总的来看,Kimi k1.5 的这份技术背后的理念就像是官方推文中引用的这句话,它介绍了模型开发中的一些技巧,而这些 trick 往往是简洁且优雅的。同时可以看出团队也在调整自己的技术公开策略,把“菜谱”分享给社区,让行业共同进步。

值得注意的是,这份报告中还列出了参与研发和数据标注工作的人员名单,相对于 K1.5 出色的表现,贡献者名单其实很精炼,这可能印证了 Kimi 团队的某种人才密度。

RL+LLM,大道至简?

英伟达高级研究科学家 Jim Fan 第一时间对 Kimi 和 DeepSeek 两家公司发布的强化学习(RL)相关论文的评价和对比,他认为两家公司都得出了一些相似的发现,也就是简化强化学习框架,同时提升推理性能和效率。

无需复杂的蒙特卡洛树搜索(MCTS),而是线性化推理过程,结合高质量的自回归预测。不需要依赖额外昂贵的模型副本来处理价值函数。不需要复杂的奖励建模,只需依赖于高质量的真实数据和最终结果。

这或许就是 o1 已经被“破译”的秘密,没有 PRM,没有 MCTS,没有复杂的配方,大规模可验证的数据让推理和自我反思在任何 RL 算法中涌现。

一直以来,中国人工智能企业由于在 GPU 上的限制,更倾向于在算法和模型设计上追求高效,降低资源消耗,例如通过框架简化、模型蒸馏和数据驱动的方法,这可能正好契合了 o1 背后的技术的趋势。

最近,除了发布 R1,长期专注研究技术的 DeepSeek 开始招聘 C 端产品相关人才,并低调上线了 C 端产品;Kimi 也第一次发布模型训练技术报告,在澄清某些传言的同时,释放出招揽技术人才的信号。与此同时,字节、通义、MiniMax、生数、面壁等企业也在纷纷推出新模型产品,大模型行业又热闹起来了,可以预见的是,新的一年,行业竞争也将进一步加剧。

扫码关注公众号

获取更多技术资讯