OpenAI悄悄招募了Altman投资的安全团队,但与超级对齐无关

HelloKitty • 2024-05-28 15:10

2535

本文由 甲子光年 撰写/授权提供,转载请注明原出处。

文章来源于:甲子光年

作者:赵健

在 OpenAI 首席科学家伊利亚·苏茨克维(Ilya Sutskever)宣布离职 8 天后,OpenAI 悄悄招募了一整个安全相关的团队。

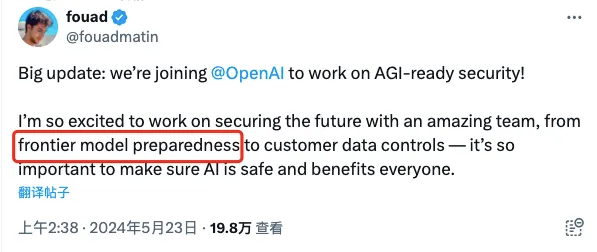

这个团队名叫「Indent」,是一家位于美国加利福尼亚州的数据安全初创公司。5 月 23 日,Indent 的联合创始人、CEO 阿福德·马丁(Fouad Matin)在 X 上宣布自己将加入 OpenAI 负责安全相关的工作。

图片来自X

虽然双方并未宣布细节,但 Indent 这家公司大概率将全部并入 OpenAI。Indent 在其网站上宣布,“经过仔细考虑,我们做出了一个非常艰难的决定,Indent 将在未来几个月内关闭”,“7 月 15 日之后服务将停止使用”。

值得一提的是,OpenAI CEO 萨姆·奥尔特曼(Sam Altman),曾在 2021 年参与了 Indent 560 万美元的种子轮融资,双方算是老相识了。

近期 OpenAI 风波不断,其中备受关注的是在伊利亚·苏茨克维离职后引发的连锁反应,OpenAI 负责安全的超级团队的联合主管简·雷克(Jan Leike)也宣布离职。两人共同领导的超级对齐团队去年 7 月才刚刚成立,现在已经分崩离析。

然而,仔细一看就会发现,Indent 团队的加入虽然是对安全团队新鲜血液的补充,但与超级对齐团队却毫无关系。

Indent 团队的加入更加明确了一件事:萨姆·奥尔特曼正在把 OpenAI 变成一家彻头彻尾的商业化公司。

Indent 是谁?

先介绍一下 Indent 这家公司。

Indent 成立于 2018 年,从事数据安全相关业务,它所提供的服务也很简单——自动化处理访问权限的审批流程。

比如,当工程师需要查看生产服务器日志或客户支持需要敏感系统的管理员权限时,他们可以使用 Indent 的应用程序请求访问权限,而无需IT部门的帮助。审阅者可以通过 Slack 收到消息并直接从那里批准,然后一旦时间到期,访问权限就会自动撤销。

Indent 为公司中的每个人提供按需访问控制,让他们可以在需要时访问自己需要的内容。

这项看似简单的服务解决了一个重要的需求——随着团队规模的扩大,越来越多的员工需要访问越来越多的服务,而这些服务的审批可能需要几天、几周甚至几个月的时间。当然可以简化审批流程,但最简单的方法往往不是最正确的方法,因为这可能带来安全问题。如果涉及到关键业务,在几个小时内回复客户还是几天内回复客户将会带来完全不同的结果。

许多公司至少使用几十个应用程序来处理不同团队的关键服务、协作或客户数据,每个应用程序都有几十个不同的潜在角色或子权限,这很容易失控。

而 Indent,就是为团队提供最简单、最安全的方式来实现民主化的访问管理和问责制度。

2023 年,在大模型兴起之后,Indent 将数据安全的业务顺势拓展到了大模型领域。

2024 年 3 月,Indent 联合创始人、CEO 阿福德·马丁发表了一篇文章《价值百万美元的人工智能工程问题》。

他提到,模型权重、偏差和训练它们所用的数据是人工智能皇冠上的明珠,是公司最宝贵的资产。对于开发定制模型或微调现有模型的公司来说,他们会在工程时间、计算能力和训练数据收集上投入数百万美元。

但是,大语言模型存在泄露的风险。他以Llama举例,Meta 一开始并没有考虑将 Llama 完全开源,而是做出一些限制。然而,有人却将其泄露在了 4chan 网站上。Meta 不得不顺水推舟,将 Llama 完全开源了。

因此,Indent 针对性地提出了模型权重、训练数据、微调数据的安全解决方案。

与 Altman 渊源颇深

Indent 与 OpenAI 双方的渊源由来已久。

Indent 有两位联合创始人,阿福德·马丁(Fouad Matin)担任 CEO,丹·吉莱斯皮(Dan Gillespie)担任 CTO。

阿福德·马丁是一位工程师、隐私倡导者,也是街头服饰爱好者,他之前在 Segment 公司从事数据基础设施产品的工作。2016 年,他与别人共同创立了 VotePlz,这是一个非党派的选民注册和投票率非营利组织。他热衷于帮助人们找到令人满意的工作,此前他创立了一家通过 YC W16 计划的推荐招聘公司。

丹·吉莱斯皮是第一个非谷歌员工管理 Kubernetes 发布的人,并且自项目早期以来一直是定期贡献者。作为他进入 K8s 的起点,他是一家协作部署工具的联合创始人兼 CTO(YC W16),在那里他构建了 Minikube。他的公司被 CoreOS 收购,后来 CoreOS 成为了 RedHat 的一部分,随后又成为 IBM 的一部分。

通过履历可以看出,两人早年间与 YC 关系紧密。而萨姆·奥尔特曼在 2011 年投入了创业孵化器 YC,并 2014 年担任 YC 总裁,直到 2019 年担任 OpenAI CEO。

2021 年 12 月 21 日,Indent 宣布获得 560 万美元的种子轮融资,领投方包括 Shardul Shah(Index Ventures 合伙人)、Kevin Mahaffey(Lookout 首席技术官)和 Swift Ventures,而跟投方的豪华阵容中,就包括萨姆·奥尔特曼以及他的弟弟杰克·奥尔特曼(Jack Altman)。

图片来自Indent网站

双方紧密的关系,以及日后 Indent 涉足大模型安全领域,为 Indent 并入 OpenAI 做好了铺垫。

Indent 并非加入超级对齐

将 Indent 一整个团队招募至麾下,是 OpenAI 对于超级对齐团队的补充吗?答案是否定的,因为这是两个完全不同的团队。

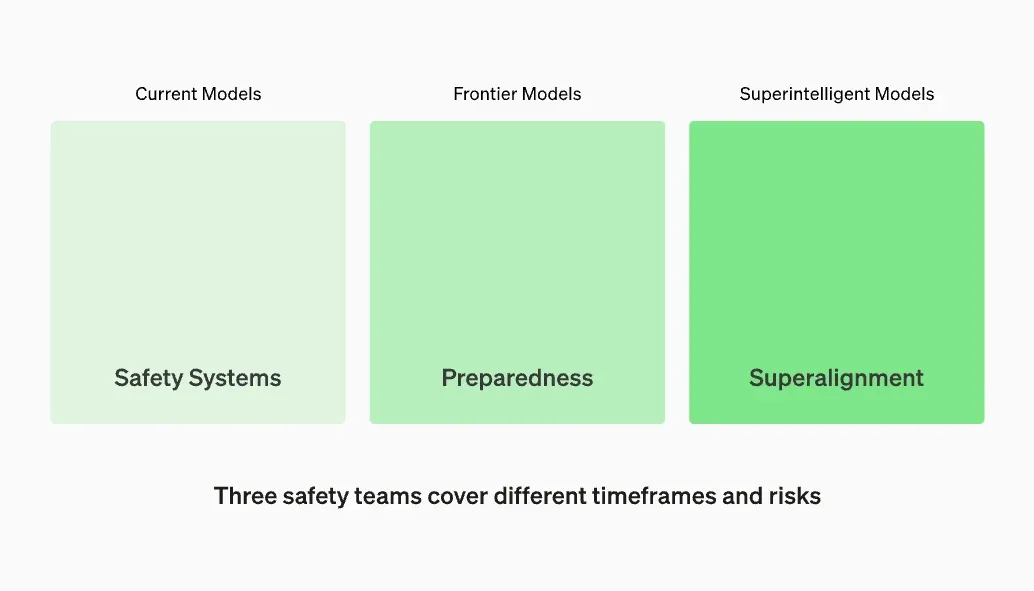

OpenAI 的安全团队实际上一共有三个:安全系统团队(Safety Systems)、准备团队(Preparedness)、超级对齐团队(Superalignment)。

三个团队的分工为:安全系统团队关注当前模型的部署风险,专注于减少对现有模型和 ChatGPT 等产品的滥用;准备团队专注于前沿模型的安全评估;超级对齐团队专注于协调超级智能,为在更遥远的未来拥有的超级智能模型的安全性奠定基础。

图片来自OpenAI网站

安全系统团队是一个相对成熟的团队,分为四个子系统:安全工程、模型安全研究、安全推理研究、人机交互,汇集了一支多样化的专家团队,包括工程、研究、政策、人工智能协作和产品管理等领域的专家。OpenAI 表示这种人才组合已被证明非常有效,使 OpenAI 能够接触到从预训练改进和模型微调到推理时监控和缓解的广泛解决方案范围。

准备团队对前沿人工智能风险的研究远远没有达到需要达到的水平。为了弥补这一差距并系统化安全思维,OpenAI 在 2023 年 12 月发布了一个名为“准备框架”的初始版本,它描述了 OpenAI 跟踪、评估、预测和防范日益强大的模型带来的灾难性风险的过程。

图片来自OpenAI

OpenAI 还表示将成立一个专门的团队来监督技术工作,并建立安全决策的运营结构。准备团队将推动技术工作,以检查前沿模型能力的极限、进行评估并综合报告。OpenAI 正在创建一个跨职能的安全咨询小组,以审查所有报告并同时将其发送给领导层和董事会。虽然领导层是决策者,但董事会有权推翻决定。

超级对齐团队是 2023 年 7 月 5 日刚刚成立的新团队,旨在在 2027 年之前用科学与技术来引导和控制比人类聪明得多的人工智能系统。OpenAI 宣称会用公司 20% 的计算资源投入这项工作。

关于超级对齐还没有明确可行的解决方案。OpenAI 的研究方法是,用已经对齐的小模型来监督大模型,然后通过逐步扩大小模型的规模来逐步对齐超级智能,并对整个流程进行压力测试。

OpenAI 超级对齐团队由伊利亚·苏茨克维和简·雷克共同领导,但两人现在已经离职。据媒体报道,在两人离职后,超级对齐团队已经分崩离析。

Indent 团队并非加入超级团队。根据 Indent 团队在 X 上发布的信息,他们加入的是 OpenAI 的准备团队,负责前沿模型的准备到客户的数据管理。

图片来自X

这意味着 OpenAI 正在加大前沿模型的投入。

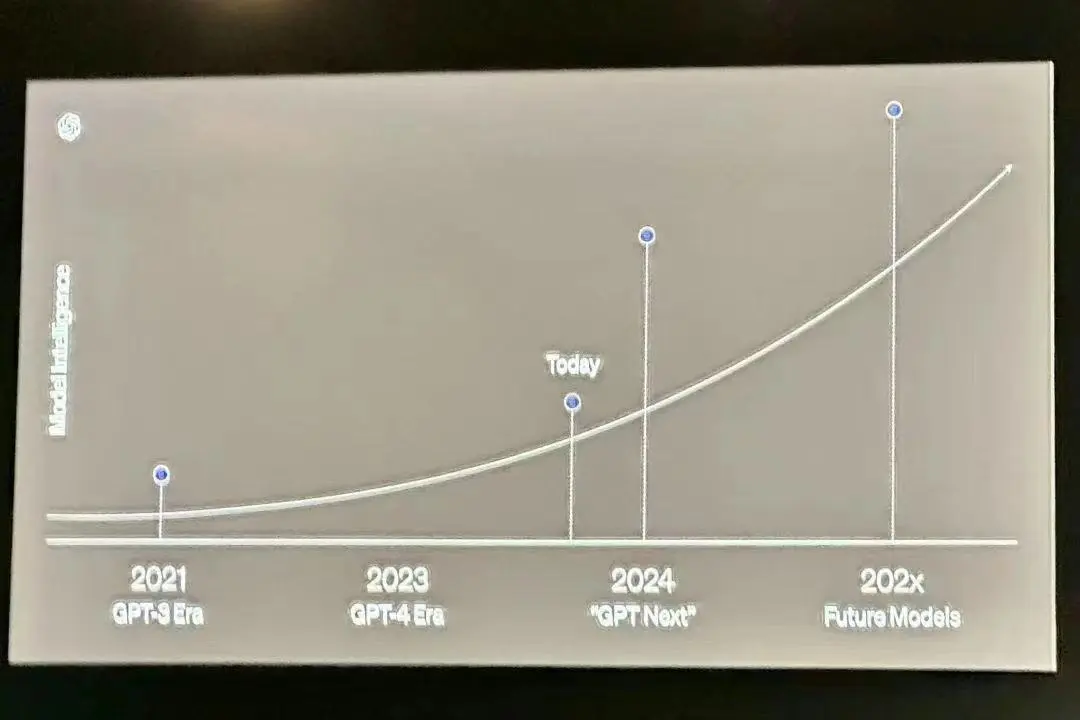

近期在法国巴黎举办的 VivaTech 峰会上,OpenAI 开发者体验主管 Romain Huet 展示的 PPT 里,透露了 OpenAI 的下一款新模型“GPT Next”将在 2024 年晚些时候发布。

图片为OpenAI在VivaTech分享的PPT,来自X

OpenAI 接下来的工作重心,很可能就在这款新模型的能力与安全上。

OpenAI 的“原罪”

超级团队的解散、Indent 团队的加入,如果把一系列相关事件串在一起,只能得出一个结论:OpenAI 正在加速追求模型的落地与商业化。

这一点,在超级对齐团队主管简·雷克的离职声明中已经公开化了。

简·雷克认为应该把更多的带宽花在为下一代模型做准备上,包括安全、监控、准备、对抗稳健性、超一致性、机密性、社会影响和相关主题,但过去几个月他的团队“却为计算资源苦苦挣扎”——连最初承诺的 20% 的计算资源也不能满足了。

他认为,OpenAI 的安全文化与流程已经不再受重视,而光鲜的产品备受青睐。

图片来自X

对此,在 OpenAI 总裁格雷格·布罗克曼(Greg Brockman)长篇大论的回应里有这么一句话:

我们认为这样的(越来越强大的)系统将对人们非常有益和有帮助,并且有可能安全地交付它们,但这需要大量的基础工作。这包括在训练时它们连接到什么的周到考虑,解决可扩展监督等难题的解决方案,以及其他新型的安全工作。在我们朝着这个方向构建时,我们还不确定何时能达到我们的安全标准来发布产品,如果这导致发布时间表推迟,那也没关系。

图片来自X

前面提到,OpenAI 在成立超级对齐团队时,把引导与控制比人类聪明得多的超级智能系统的时间表设立在了 2027 年。格雷格·布罗克曼的回应相当于更改了这一时间表——“如果延迟发布,也没有关系”。

需要强调的是,OpenAI 并非不重视安全,但显然它对安全的重视需要加上一个条件——一切安全都要以可落地的模型、可商业化的产品作为前提。显然,在资源相对有限的前提下,即使是 OpenAI 也要做一个取舍。

而萨姆·奥尔特曼倾向选择做一个更纯粹的商人。

安全与商业化是矛盾的吗?对于世界上其他的所有公司,这并非一个矛盾。但 OpenAI 就是那一个例外。

2023 年 3 月,在 GPT-4 发布后,埃隆·马斯克曾发出过灵魂拷问:“我很困惑,我捐赠了一亿美元的非营利性组织,怎么就变成了一个市值 300 亿美元的营利组织?”

在 OpenAI 宫斗事件发生时,外界已经或多或少猜测到了矛盾的导火索就是由此产生。今年 3 月 8 日,调查结果出炉后,OpenAI 在官方通告中除了表示萨姆·奥尔特曼回归之外,还宣布了公司会对治理结构做出重要改进,包括“采用一套新的公司治理准则”、“加强 OpenAI 的利益冲突政策”等。

只是,直到 OpenAI 的超级团队的解散,我们也没有等到新的政策。这可能才是很多离职员工对 OpenAI 失望的原因吧。

(封面图来自Indent)

*插播一条消息:在全球化的时代浪潮中,AI+跨境电商正迎来前所未有的发展机遇,为了让不同领域的企业聚集在一起,展示在AI跨境电商领域的服务和产品,促进行业内的信息流通和合作机会,白鲸跨境与白鲸技术栈正在招募一群富有激情和创造力的伙伴,共同绘制AI+跨境电商的生态图谱!如有感兴趣者,可点击下方链接进行报名。

AI+跨境电商图谱招募令报名链接:https://www.baijing.cn/activity/1636

扫码关注公众号

获取更多技术资讯