昆仑万维方汉:一年读200篇AI论文后,找到了大模型的最佳赚钱模式

HelloKitty • 2024-04-19 16:09

2263

本文由 甲子光年 撰写/授权提供,转载请注明原出处。

文章来源于:甲子光年

作者:赵健

互联网公司转型做大模型是否靠谱?昆仑万维正在寻找适合自己的机会。

这家成立于 2008 年的互联网公司依托于游戏起家,业务覆盖社交、娱乐等多个领域。2022 年,昆仑万维看到了生成式 AI 在绘画等领域的颠覆式革命,宣布“All in AIGC”。2023 年,昆仑万维陆续发布基础大模型「天工」以及天工 AI 搜索等多个 AI 产品。

2024 年开年,昆仑万维发布全新公司愿景,将“实现通用人工智能,让每一个人更好地塑造和表达自我”为使命。

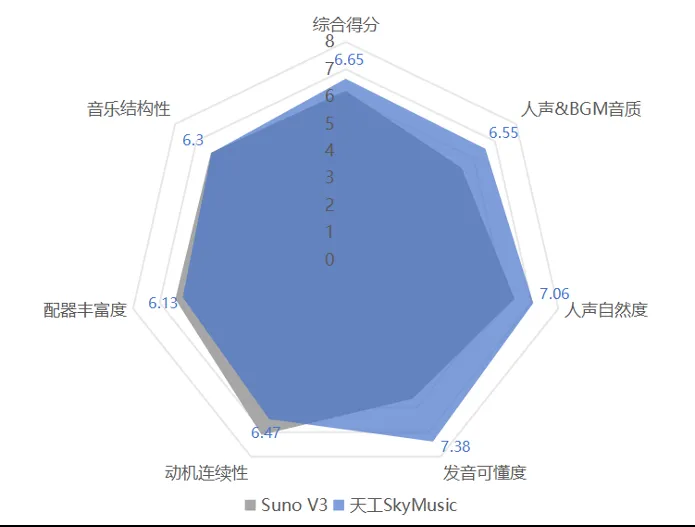

今天,昆仑万维宣布,「天工 3.0」基座大模型与「天工 SkyMusic」音乐大模型正式开启公测。「天工 3.0」拥有 4000 亿参数,超越了 3140 亿参数的 Grok-1,是全球最大的开源 MoE 大模型;「天工 SkyMusic」则是中国首个音乐 SOTA(State Of The Art)模型,在人声 &BGM 音质、人声自然度、发音可懂度等领域显著领先Suno V3。

为了做好大模型,昆仑万维做了很多准备。

在算力层面,昆仑万维有近万卡的训练资源,足够支撑训练下一代基于多模态的 MoE 大模型以及视频生成大模型。

在技术上,为了与业内最先进的技术保持同步,昆仑万维董事长兼 CEO 方汉每周要阅读 3~4 篇技术论文,2023 年一共阅读了 200 多篇论文;还会在一线写代码,写 prompt,他写 prompt 的能力可能超过公司 90% 的同事;公司所有的算法博士,几乎都是方汉亲自面试的。

在商业模式上,方汉认为移动互联网时代“免费+to C”的模式依然适用于 AI 时代。只有“免费+to C”,才会产生 AI 时代的巨头。这是目前最合适的商业模式,也最容易盈亏平衡,赢得正向 ROI。

为了实现这一点,大模型必须降低推理成本,终局是端侧推理,而中局则是大模型底座+AI UGC 平台——这也是昆仑万维选择的路线。

近日,「甲子光年」与昆仑万维董事长兼 CEO 方汉进行了一次对话,详细解释了昆仑万维打算如何通过大模型来赚钱。

降低推理成本才能免费

方汉判断,下一代的 AI 巨头与互联网、移动互联网时代的巨头模式相似,一定是“C 端+免费”,因为全球 C 端用户有 80 亿,市场上限是最高的,任何一个微小的收入乘以 80 亿都是一个非常惊人的数字。

目前,国外很多大模型企业采用订阅模式,比如 OpenAI。基于订阅模式,方汉算了一笔账:假设一个月的订阅费是 19 美元,全世界愿意花钱订阅的用户可能只有 1 亿人左右,剩下的 79 亿人还是要靠免费模式。

如何实现免费模式?方汉认为有三条路径。

第一条路径是降低推理成本。如果把大模型的推理成本降到现在的千分之一、万分之一,几乎就可以免费给大家用。但是,降低推理成本与提升模型能力会互相掣肘。方汉表示,现在推理成本几乎以每年十倍的比率在下降,但模型的能力也在以几十倍的速度提升(带来成本的提高),就像“两头驴在拉磨”。

除了通过技术与工程上的优化来降低成本外,还有一种用“小模型”降低成本的方式。比如,我们今天经常使用的 ChatGPT,并非是一个 1750 亿参数的模型,而是优化到了 80 亿参数。方汉表示,昆仑天工也是类似的逻辑,天工 3.0 虽然是一个 4000 亿参数的 MoE 模型,但实际上并非所有的服务都是调用这个大参数模型,而是蒸馏出很多小模型为用户服务。

第二条路径是采用 UGC 平台模式,即让 1% 的内容创作者使用付费 AI,剩下 99% 的读者免费看其生产的内容,这样推理成本大约降低了 100 倍,商业模式会更加容易成立。

第三条路径是端侧推理,比如 AI PC 与 AI 手机,但 AI 手机要 3~5 年后才会普及,因为用户的换机需要一个周期。方汉表示:“这就像 4G 和手机摄像头推动了短视频行业的发展。如果没有摄像头,没有手机摄像头,没有 4G 网络,短视频行业是永远不会出现的。”

如果 AI 手机普及,市场规模就会变得空前巨大。技术上没有难点,经过工程师的优化,手机端可以推理 7B 和 13B 的模型,这已经满足了用户 70% 至 80% 的需求。

方汉认为,在 AI 手机普及之前,UGC 平台就是一个中期的最佳商业模式。昆仑天工就是选择做一个基于大模型基座驱动的 UGC 平台。

大模型底座 +AI UGC 平台

昆仑万维目前有六大业务矩阵:AI 大模型、AI 搜索、AI 音乐、AI 视频、AI 社交、AI 游戏,本质上是两条业务线——底层做通用大模型的底座,上层做 AI UGC 平台。

为什么一定要亲自下场做基座大模型?方汉解释道:“从技术角度来看,人类的智慧是以文本形式沉淀下来,所有的社交、游戏、音乐跟视频的专属模型,其实都需要文本大模型的能力去支撑。比如,训练视频模型的视频数据,就需要用文本模型打标,文本模型的能力决定了用户输入 prompt 的遵从能力有多强,以及最后生成的视频关联性有多强;著名的 Stable Diffusion 模型把文本模型从 CLIP 换成了 T5 之后,能力极大提高。”

为了做好基座大模型,昆仑万维也储备了近万卡的训练资源,足够支撑训练下一代基于多模态的 MoE 大模型和视频生成大模型。对于国产芯片的适配,昆仑万维也在内部做过很多测试,某国产芯片的最新版本在性能上大约能到英伟达 H100 的 80%。

而从商业角度来说,方汉也提到,拥有基座大模型,才能够保证不会被“釜底抽薪”。类似的事件其实已经上演过,基于其他基座大模型做应用的公司,会面临中止合作的风险。

在应用层,昆仑万维的产品矩阵目的就是要打造一个以 IP 为核心的综合 UGC 平台。

方汉表示,一个 IP 基本上是在小说与漫画里产生,比如哈利波特、指环王与漫威,而具体的变现方式就是视频与游戏,这是一个 IP 的完整闭环。用户其实并不太关心是文本、漫画还是视频的形式,他只在乎能否讲好一个故事,这个故事实际上就是 IP。如果你能生成新的 IP,用户就会愿意在你的平台上消费。昆仑天工的 AI UGC 平台,就是想让所有用 AI 创作的人在里面完成IP的全闭环。

对于产品的增长预期,方汉表示“不想当将军的士兵不是好士兵”。目前来看,技术最好的产品——即达到 SOTA 的产品,就能获得最多的用户。因此,只要在垂类上取得 SOTA,既可以是领域也可以是语言,就一定能获得高速增长能力。

昆仑天工今天开启公测的天工音乐大模型,就是音乐领域的 SOTA 模型。

天工SkyMusic综合性能超越Suno V3,图片来自昆仑万维

根据现在的进展,方汉相信,所有 AIGC 技术将会在两三年后达到一个足够可用的高度。

大模型公司一定是技术老大做 CEO

在竞争激烈的大模型赛道,昆仑万维如何保证技术的领先性?

方汉认为不断前进的原则只有一个,就是好奇心。“只要你对这个世界充满好奇,你就可以不断地前进,而前进的具体手段,我认为没有别的办法,就是深入一线,接触技术。”

这一波大模型跟原先不一样,最大的特点是技术驱动,基本上创业公司都是技术老大做 CEO。

方汉是技术出身,大学的专业是核物理,毕业后被分配到了中国高能物理研究所,是全中国第一个接入互联网的单位。方汉表示自己对于技术的好奇是无穷无尽的。

方汉每周要阅读 3~4 篇技术论文,2023 年一共阅读了 200 多篇论文;还会在一线写代码,写 prompt,“我敢说我写 prompt 的能力可能超过公司 90% 的同事”;公司所有的算法博士,几乎都是他亲自面试的。

方汉自勉道:“作为公司管理者,如果不去读论文,你就不知道技术的边界在哪里,就没有办法为这个边界设计产品与商业模式。如果不懂技术,别人高维打低维,技术指标把你碾压了,你就全完蛋了,就像 GPT 套壳公司在 GPT Store 出来后全军覆没一样。对我而言,与业界保持同步的唯一办法就是读论文,跟技术同学交流,我们公司的管理层也都是这样。”

方汉认为,只要决策者知道技术的边界在哪里,所有的规划都不会有问题。

除了站在技术一线,昆仑万维也非常重视人才的引进。

2023 年 9 月,AI 大牛颜水成加入昆仑万维,担任天工智能联席 CEO、2050 全球研究院院长。方汉透露,2050 全球研究院已经有多位教授和博士加入。

方汉还观察到一个现象,由于大模型的出现,所有的技术栈都是全新的,导致这个赛道里能力最强的其实是在校博士、研究生,而不是毕业多年的人。他发现,关于大模型的论文,在校博士发布的东西是最有创意、最有想法的。

开源与闭源之争

就在昆仑天工 3.0 大模型宣布公测的前一天,百度董事长兼 CEO 李彦宏在 Create 2024 百度开发者大会上针对开源与闭源路线发表了一番有一定争议的观点。李彦宏表示,在当今的大模型生态下,开源模型会越来越落后。

方汉也分享了他对开源与闭源之争的看法。

首先,开源到底有没有商业模式?在软件行业,开源一直是一个很有争议性的话题。

上个世纪末,在软件行业发展的早期,开源的确没有很好的商业模式,那时候的商业模式只有一个:收取服务费。当时最赚钱的公司是 Red Hat,后来被 IBM 收购。

后来,一家软件公司的出现改变了开源的商业模式——MongoDB。MongoDB 发现,云服务商都在用开源产品提供服务来赚钱,但却不给开源组织一分钱。于是,MongoDB 推出了一个 SSPL 产品授权协议,所有用户可以免费使用,但云服务商除外,除非云服务商可以支付费用。

开源的另一个商业模式,是把开源当成一种最便宜的获得销售线索的手段。产品开源之后很多用户会来试用,遇到问题还得找原厂解决售后问题。国内一些开源数据库采用了这种方式。

因此,方汉认为,开源仍然是有商业模式的。

从技术角度出发,开源与闭源模型谁更有优势?

目前大模型评测的方法有很多种,方汉认为最具权威的测试方法是大模型竞技场(LLM Arena)。2023 年以来 GPT-4 都是常年的第一名的位置,Claude 3 发布后短暂超越 GPT-4,近期最新版本的 GPT-4 Turbo 又重新夺回第一。

大模型竞技场排行榜,图片来自LMSYS Chatbot Arena

如果看开源模型,目前大模型竞技场的榜单上排名最高的开源模型是阿里的 Qwen1.5-72B-Chat,排名第十一。方汉认为,开源模型与闭源模型的差距已经从落后 2 年以上,追到仅落后 4~6 个月了,这证明了两者的差距是在缩小而非加大。

从另一个文生图赛道来看,开源模型的优势会更加明显。

文生图领域有两个代表性的 SOTA 闭源模型:DALL-E 与 Midjourney,但在开源的 Stable Diffusion 出来之后,很多游戏领域的美术工作流都逐渐采用了 Stable Diffusion,背后的一部分原因在于计算资源。

方汉表示,大学与高校里的博士生与老师其实是十分尴尬的,因为他们没有太多的计算资源,只有基于开源的 Stable Diffusion 去做工作,他们的聪明才智也只好贡献给了开源模型。因此,开源模型实际上是一种生态构建器,更有利于满足于用户的长尾需求。

方汉认识两位中国的个人模型作者,一位是给文身师设计文身图,一位是给商店画支架图,而这两种长尾需求,闭源模型是不可能满足的,只有靠开源模型才能定制。

方汉认为,开源模型与闭源模型是一个生态的组成部分,不是谁取代谁,而是一个互补关系,都会有自己的生存空间。

(封面图来自《钢铁侠》)

*插播一条消息:在全球化的时代浪潮中,AI+跨境电商正迎来前所未有的发展机遇,为了让不同领域的企业聚集在一起,展示在AI跨境电商领域的服务和产品,促进行业内的信息流通和合作机会,白鲸跨境与白鲸技术栈正在招募一群富有激情和创造力的伙伴,共同绘制AI+跨境电商的生态图谱!如有感兴趣者,可点击下方链接进行报名。

AI+跨境电商图谱招募令报名链接:https://www.baijing.cn/activity/1636

扫码关注公众号

获取更多技术资讯