清华五道口的宇宙里,藏着一个中国AI“扫地僧”

HelloKitty • 2023-05-06 11:12

1932

本文由 AI新智能 撰写/授权提供,转载请注明原出处。

文章来源于:AI新智能

作者:举大名耳

最近,微软总裁布拉德・史密斯在东京接受采访时的一句话,引起了人们的关注。

因为他将 OpenAI 的主要竞争对手定为了中国。

在史密斯看来,目前在人工智能领域,世界上三家公司处于绝对前列,一个是与微软合作的 Open AI,第二个是谷歌,第三个是北京智源人工智能研究院 ( 以下简称智源 )。

这个被微软总裁亲自点名的中国机构,究竟是何方神圣?

事实上,尽管名头相当低调,但这家研究院却是国内不折不扣的大模型“先行者”之一。其推出的大模型“悟道 2.0”, 参数量达到了惊人的 1.75 万亿,这是 GPT-3.5 的十倍。

并且,这家机构其实很年轻——2018 年创建,诞生至今也不过五年。

那么,这个既低调、又年轻的机构,究竟是如何在如此短的时间内,取得了比肩谷歌与微软的技术实力,并成为深藏不露的“世界前三”的?

生于逆境

可以说,智源的诞生,是中国 AI 界在逆境中被“逼”出来的产物。

2018 年,第一代 GPT 发布,包含 1.17 亿个参数,虽然效果一般,但已经和国内拉开了差距。

当时中国的人工智能领域,在各个方面均处于一种“黯淡”的状态。

在当年上榜的机构和企业数量中,中国仅有一家企业(国家电网)在人工智能领域的论文数量能跻身全球企业前 20。

而当时,中国在人工智能杰出人才数量上的占比,是人工智能人才总量前十国家中最低的,仅占到本国人工智能人才总量的 5.4%。

面对如此差距和困境,那年 11 月,在科技部和北京市委的支持下,北大、清华、中国科学院、百度、小米、字节跳动、等北京人工智能领域优势单位,共同建立了一个新型的研究机构,希望以此一改国内人工智能“乏力”的局面。

这个机构,就是今天位于北京海淀区成府路 150 号的智源研究院。

智源诞生后,实行理事会领导下的院长负责制,由美国国家工程院外籍院士张宏江担任理事长,北京大学信息科学技术学院教授黄铁军担任院长。

智源研究院的员工集合了一支包括清华、人大、北大等知名学府以及各合作企业组成的,不同专业方向的团队。

身为理事长的张宏江,是世界计算机领域影响因子最高的科学家之一(位居中国大陆第一),曾担任IEEE多媒体学刊的主编,拥有超过 180 项国际专利,出版4本学术专著、发表400多篇学术论文。

理事长张宏江

智源研究院学术委员会主席的张钹,不仅是清华大学计算机系教授,中国科学院院士,也是中国人工智能领域奠基人之一。

其在人工智能、人工神经网络等领域,已发表 200 多篇学术论文和 5 篇专著。

张钹院士

担任智源研究院副院长、总工程师的林咏华,不仅曾任 IBM 中国研究院院长、IBM 全球杰出工程师、并且具有多年人工智能(视觉分析)、系统架构、云计算的创新研发和管理经验。

科研上,林咏华有超过 50 项全球专利,多篇学术文章发表在顶级国际会议和期刊。

智源研究院副院长林咏华

智源庞大的人才队伍,不仅汇聚了中国 AI 圈内的顶尖人才,其涉及的研究方向也颇为全面,包括 AI 数理基础、AI 认知神经基础、机器学习、自然语言处理等。可以说涵盖了大模型领域必备各个的知识体系。

除了顶尖的研究团队,智源所拥有的雄厚技术优势,也是让微软觉得其不可小觑的原因。

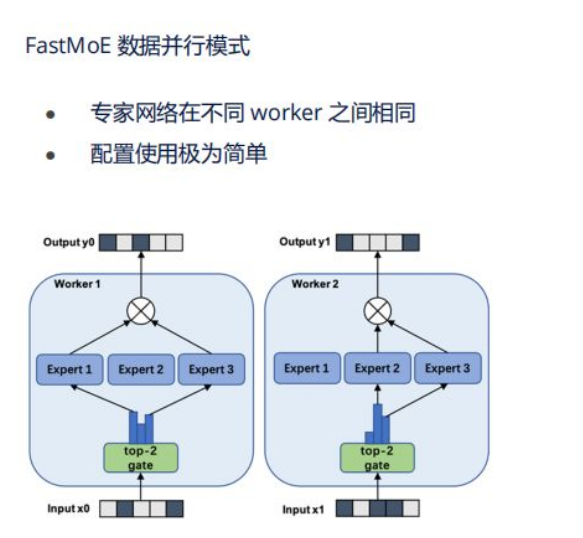

2020 年,智源研究院和清华大学联合发布了首个支持 PyTorch 框架的高性能 MoE 系统FastMoE。

这是一种支撑万亿模型的核心技术。

通过将神经网络分成多个子网络(也称为专家),FastMoE 能将一个大任务分成多个小任务,每个小任务由一个“专家”来完成,这样做就可以让任务更加高效地完成。

其在大模型领域的意义,相当于建筑工程中的“扩大梁柱间距、增加支撑点”,能够显著提高模型的准确性和泛化能力,让模型支持大规模并行训练,扩展了模型的规模。

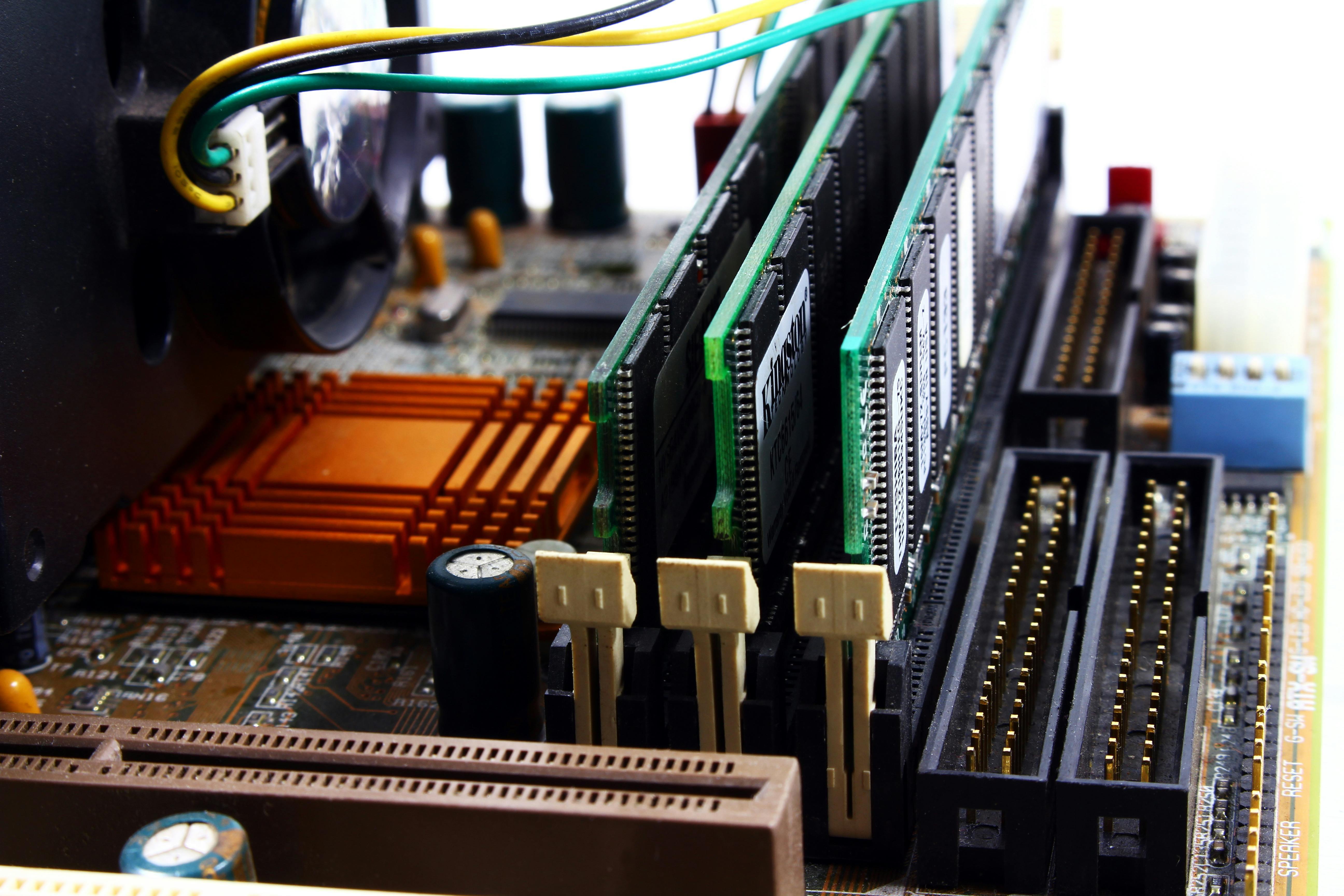

除此之外,在 2022 年,智源还打造了拥有 1000P 算力池——九鼎智算平台。

在这里,P 是一个数量级,10 的 15 次方,1000P 就是 100 亿亿,1000PFlops 算力就意味着每秒有 100 亿亿次的浮点运算能力。

一个 Atlas 800 组成的 AI 算力集群,以 1000P 算力为例,一个时钟周期可以进行“100 亿亿”次计算。

以对 20 万颗星体的数据探索为例,传统方式需要一个有经验的科学家用 169 天才能完成,而在 1000P 的算力下,只需要 10.02 秒。

九鼎智算平台的建成,不仅打破了以往 AI for Science 等方向的算力限制,也让类似 chatGPT 这样超大参数量的大模型的训练成为了可能。

在人才、技术、算力的综合支持下,智源团队在大模型方向上的结晶——悟道 2.0,终于诞生了。

悟道 2.0

目前,悟道 2.0”模型的参数规模达到 1.75 万亿,是 GPT-3 的 10 倍,打破了之前由 Google Switch Transformer 预训练模型创造的 1.6 万亿参数记录。是中国首个、全球最大的万亿级模型。

当然,参数量越大不代表模型性能一定越好,悟道 2.0 的出众之处,也在于其“精准”的特点。

悟道 2.0 在世界公认的 9 项 Benchmark 基准测试任务上取得优异成绩,达到了精准智能。

“悟道 2.0”的高精度来自于一系列核心,例如:

GLM2.0:

GLM2.0 是模型架构创新的典范,更通用的预训练模型,GLM2.0 模型可以同时处理多种自然语言处理任务,而不需要使用不同的模型。

通过将不同的任务模块化,GLM 能够同时在分类、无条件生成和有条件生成三类 NLP 任务取得最优结果;在训练数据相同的前提下,其在 SuperGLUE 自然语言理解基准上的性能表现远超 BERT。

此前,凭借这样的特点,它首次打破了 BERT 和 GPT 壁垒,开创性地以单一模型兼容所有主流架构。

而新一代版本更是以少胜多的高性能人工智能典范,以 100 亿参数量,足以匹敌微软 170 亿参数的 Turing-NLG 模型。

P-tuning2.0 算法:

想象一下,当你只有很少的时间来学习新的东西时,你就需要更好的提示,来帮助你更快地理解和记忆。

P-tuning2.0 算法就是一种类似于这种提示的方法。

但是,不同的是,它使用连续的向量来表示提示,而不是人为设计的句子或单词。这种连续向量可以在一个连续的空间中寻找最优解,从而更好地帮助机器学习模型理解任务和学习目标。

在知识探测任务等领域,P-tuning2.0 算法的表现非常出色,可以提取高质量的知识,而且不需要额外的文本数据。因此,P-tuning2.0 算法在少样本学习中具有很高的应用价值和性能表现。

CogView:

这是一种文本生成图像的新框架,通过将 VQ-VAE 和 Transformer 进行结合,CogView 克服“上下溢收敛”文图模型关键难题。

所谓“上下溢收敛”,是指因模型结构不够复杂或者训练数据不足,导致生成的图像在训练过程中逐渐变得越来越相似,直到完全一样的情况。

而 VQ-VAE 和 Transformer,就相当于是画家手中更好的绘画工具,能让画作更精湛。

VQ-VAE 是一种用于图像和文本编码的神经网络结构,能够将输入的文本转化为潜在向量表示,而 Transformer 则能够更好地处理序列数据和文本信息,并通过选择不同的潜在向量表示,从而完成画作的生成。

目前,CogView在MS COCO FID 指标上性能优于 DALL·E 等模型。模型可直接实现类似 OpenAI CLIP 模型的自评分功能,生成国画、油画、卡通画、轮廓画等多元画风。

全链路提升:

除了上述几点外,为了提升大规模预训练模型的产业普适性和易用性,悟道团队搭建高效预训练框架,在多个方面进行了全链路的原创突破或迭代优化:

高效编码:研发了最高效、最抗噪的中文预训练语言模型编码,解决生僻字等问题。

高效模型:构建了世界首个纯非欧空间模型,处理语言中的关系和层次结构时更加高效和准确。

高效训练:世界首创大规模预训练模型融合框架,形成高效训练新模式,训练时间缩短 27.3%,速度提升 37.5%。

高效微调:世界首创多类别 Prompt 微调,只需训练 0.001% 参数即可实现下游任务适配。

高效推理:世界首创低资源大模型推理系统,单机单卡 GPU 即可以进行千亿参数规模的模型推理。

创新的基因

智源打造悟道 2.0 的最终愿景,大模型将成为一个 AI 未来平台的起点,成为类似“电”的基础建设,为社会源源不断供应智源。

2021 年,在 2021 北京智源大会上,智源研究院学术副院长唐杰就表示,悟道 2.0 后续将支持智源研究院牵头成立独立的模型商业化运营公司, 并将面向个人开发者、各个企业,分别提供模型开源、API(应用程序编程接口)调用、以及多模态的服务,赋能AI技术研发。

而要想促成这种不完全以商业利润为目标,而是以社会福利和公共利益为导向的大模型生态,就必须打造一种新的、更进步的科研体系。

这样的体系,既需要“集中力量办大事”的特点,又需要一种不计回报的,对基础研究的自由探索。

唯有“集中力量”,才能支撑起大模型愈发高昂的训练成本;

唯有“自由探索”,才能在基础理论领域打开局面,使之成为一种更普及的应用。

实际上,OpenAI 的成功,也正是基于类似的体系。

在微软与 OpenAI 建立了战略合作伙伴关系后,OpenAI 选择了一种新的股权投资协议模式:以投资回报速度代替投资回报水平。

而这种做法,是建立在 OpenAI 最终回归公益的愿景必然实现的强烈信念上。

在这样的信念下,很多顶尖的 AI 研究人员,加入 OpenAI,希望专心、自由地思考人类的终极问题。

在这一体系下,微软的资金,加上 OpenAI 的自由探索精神,最终成就了今天的 ChatGPT。

而立志要将大模型变为 AGI 时代基础设施的智源,经过探索,提出了一套自由探索+目标导向的“智源模式”:

即建立自由探索与目标导向相结合的科研管理机制,以小同行视角遴选支持智源学者自由探索,以“集中力量办大事”的科研组织模式推动“悟道”大模型等重大科研任务的实施。

而在“自由探索”这点上,智源研究院赋予了科学家最大的技术路线决定权和经费使用权,给予了科学家尽可能大的研究自由度。

而“目标导向”,就是对于学界共识的方向,智源学者们的研究能够聚焦在一个统一的愿景上,形成来自组织的合力。

托尔斯泰曾言:幸福的家庭都是相同的,不幸的家庭各有各的不幸。

而在通向 AGI 的大道上,我们也可以说:没落的团队都走了不同的歧路,但成功团队的路径总是相似的。

在大模型训练愈发消耗巨量资源的今天,我们可以预见,人类在 AGI 的成功,不会只是某一个企业的成功,而是一种新的生态,新的科研体系的成功。

扫码关注公众号

获取更多技术资讯