GPT4、ChatGPT大比拼:餐巾纸草图变网站,中文能力还是差!

HelloKitty • 2023-03-16 14:51

2308

本文由 51CTO技术栈 撰写/授权提供,转载请注明原出处。

文章来源于:51CTO技术栈

作者:云昭

一开始据说是本周四发布,结果 en~~ 周三凌晨就发布了,果真,OpenAI 向来喜欢提前给人们制造惊喜!

GPT4、ChatGPT 大比拼

废话不多说,先上 GPT4 的硬技能。

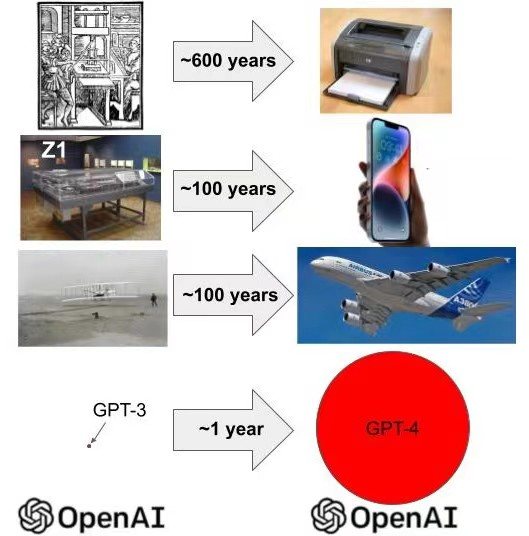

首先,是长文本处理的能力,OpenAI 官网上是这么描述的:“GPT4 能够处理超过 25,000 个单词的文本,允许使用长格式内容创建、扩展对话以及文档搜索和分析等用例。”

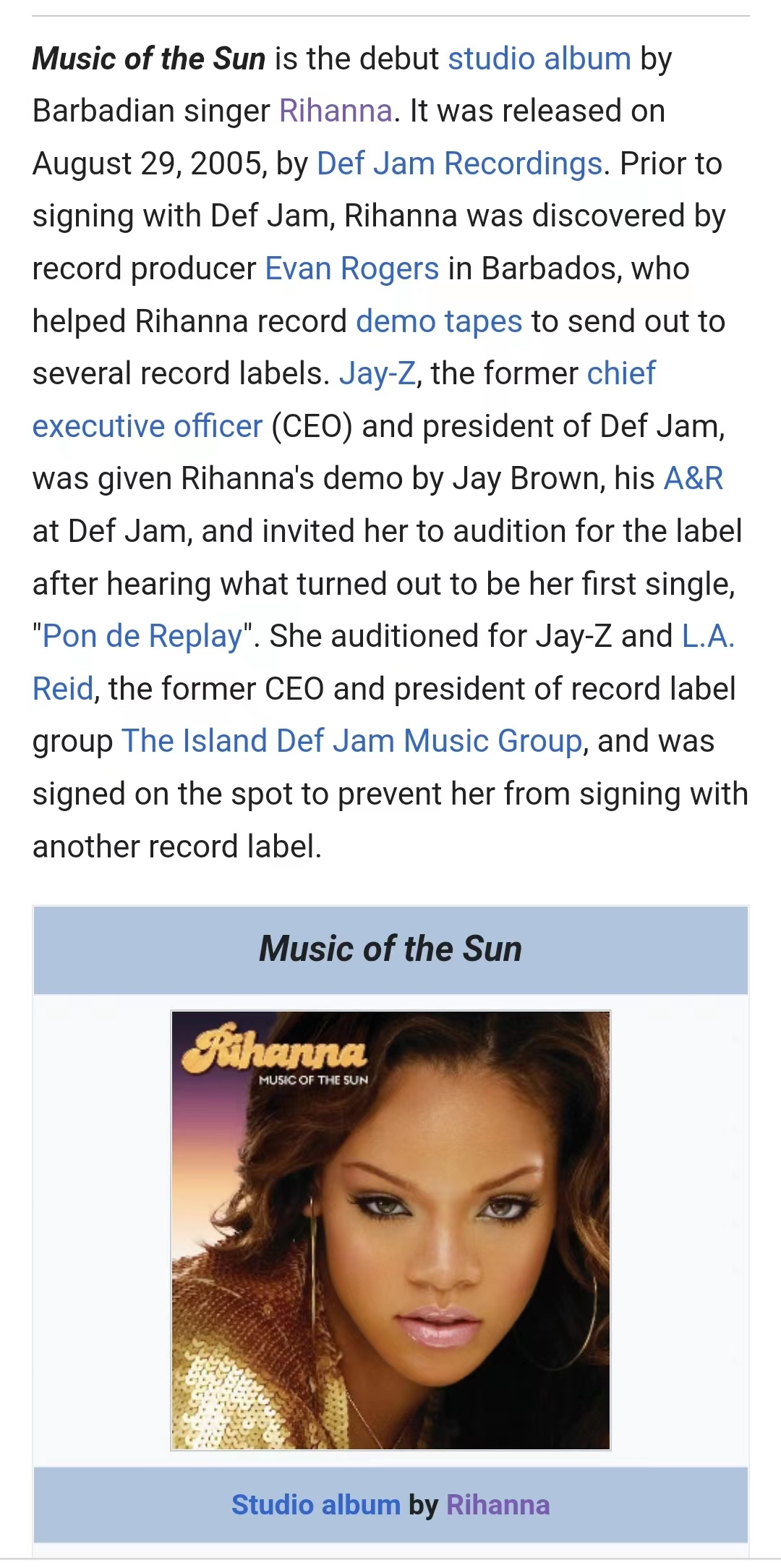

OpenAI 怕大家不能很形象的理解,干脆用一篇维基百科的长文举了个例子,这个文本有多长呢?小编实际点开了链接(见下图),要比目前 ChatGPT(GPT3.5)能处理的文本长出一倍去。不信的朋友可以去这个链接:https://en.wikipedia.org/wiki/Rihanna 看一看实际长度。

在随意的交谈中,GPT3.5 和 GPT4 之间的区别可能很细微。当任务的复杂性达到足够的阈值时,差异就会显现出来。GPT4 比 GPT3.5 更可靠、更具创造力,并且能够处理更细微的指令。

GPT4 的上下文长度为 8192 个令牌。OpenAI 还提供了对 32768 上下文(约 50 页文本)版本 gpt-4-32k 的有限访问,该版本也将随着时间的推移自动更新(当前版本 gpt-4-22k-0314,也支持到 6 月 14 日)。定价为每 1K 提示令牌 0.06 美元,每 1K 完成令牌 0.12 美元。

OpenAI 仍在改进长期环境下的模型质量,并希望得到有关它在的用例中表现如何的反馈。OpenAI 根据容量以不同的速率处理 8K 和 32K 引擎的请求,因此可以在不同的时间访问它们。

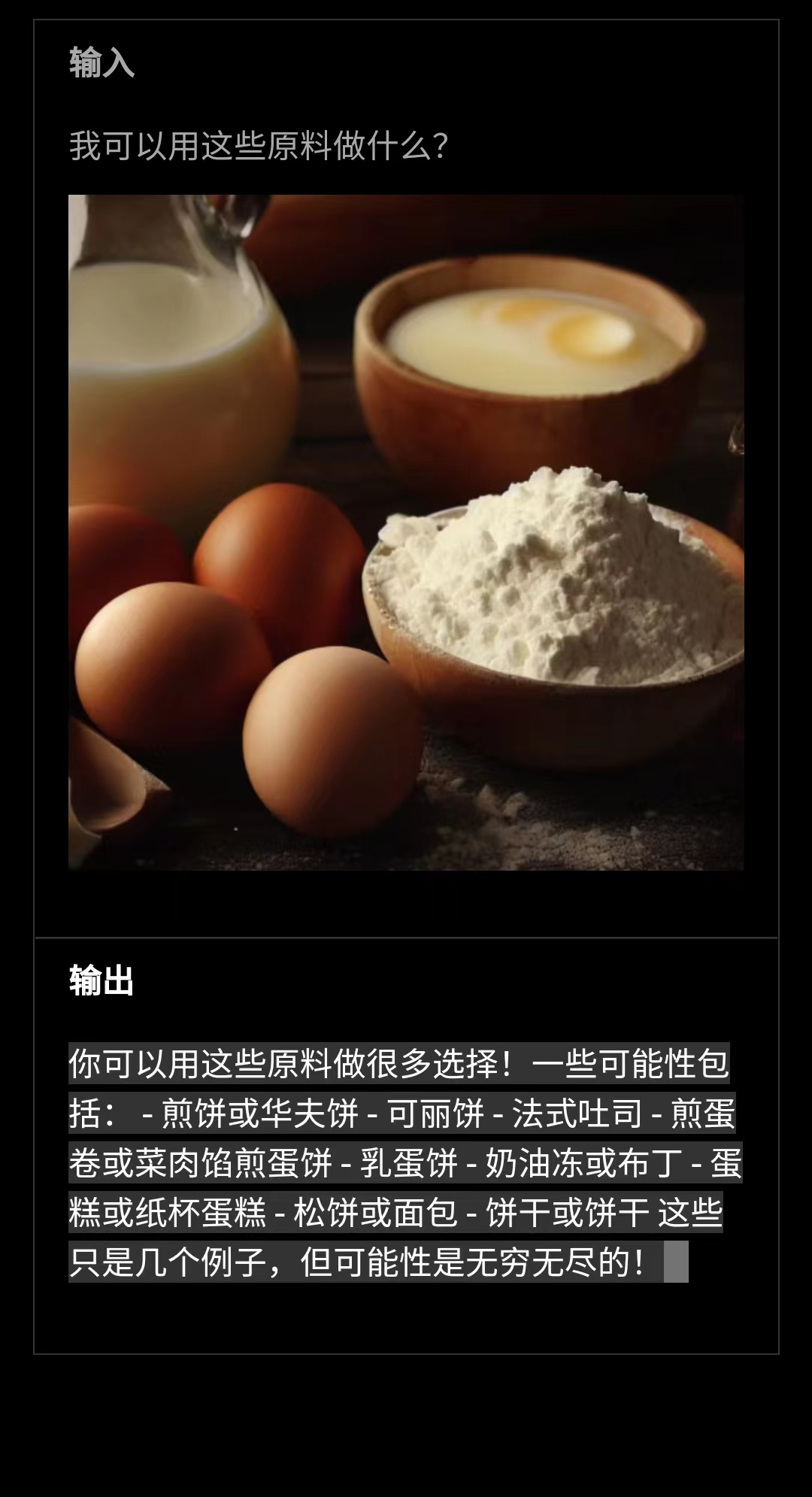

第二个,对图像的识别能力:接受图像作为输入。

GPT4 可以接受文本和图像的提示,这与纯文本设置并行,允许用户指定任何视觉或语言任务。具体来说,它生成文本输出(自然语言、代码等),给定由穿插的文本和图像组成的输入。在一系列领域,包括带有文本和照片的文档、图表或屏幕截图,GPT4 表现出与纯文本输入类似的功能。此外,它还可以通过为纯文本语言模型开发的测试时间技术来增强,包括少量镜头和思维链提示。遗憾的是,图像输入仍然只是研究预览阶段,暂时没有公开。

(问题和答案都是英文:为了便于理解,已翻译为中文)

图片上给出了一些食材,问 GPT4 可以根据图片上的食材做哪些美食。可以看出 GPT4 正式跨界了!

第三个,更靠谱的推理能力。

GPT4 较之前的模型,更具有创造性和协作性。它不仅能够完成许多创意和基础写作,而且还能创作歌曲、剧本,重要的是还能学习用户的写作风格。

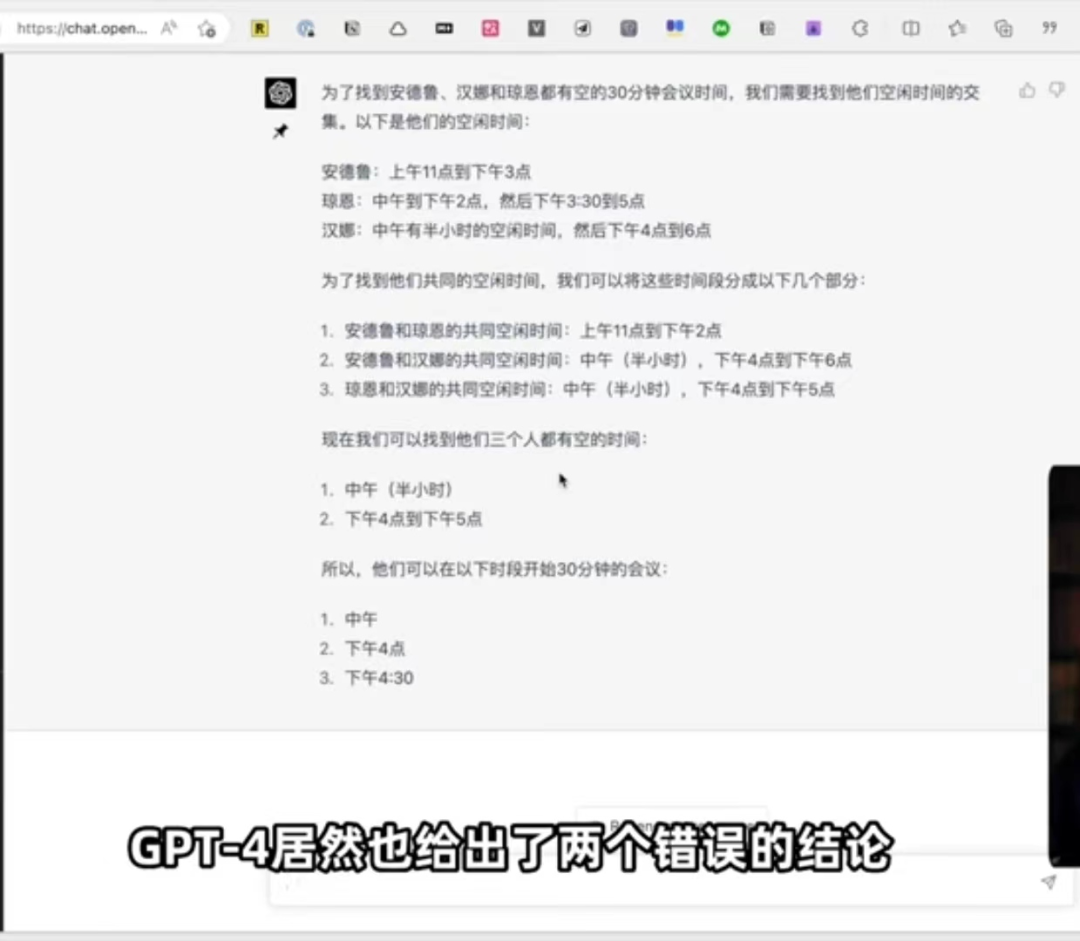

关于推理能力这块,OpenAI 还给出了一个让 GPT4 预定会议室的例子:

问题大致是这样的:三个人在每一天的空闲时间不一样,让 GPT 找出一个 30 分钟会议的合适时间。

可以看出 ChatGPT 的逻辑思路和文本分析的都没毛病,但给出的答案全错。而 GPT4 则给出了正确的答案。

GPT4 还有一个更强的 BUFF,让它参加考试,会碾压不少学霸!而 ChatGPT 则弱爆了!

在统一律师考试中取得了前10%的成绩,而 ChatGPT 获得了倒数 10%。

除此之外,OpenAI 还给出了 SAT 等其他考试的排名,均比 ChatGPT 能扛能打!

与 ChatGPT 比起来,还有哪些硬货?

GPT4 的可操作性更加灵活。使用过 ChatGPT 的朋友都知道,如果用 API 提交请求的话,一般有两个消息:系统消息(规定的 AI 风格和角色)和用户消息(具体提出的问题)。之前的 ChatGPT 对于系统消息不太看重,风格、语调比较固定。

而 GPT4 则不然,开发人员(以及很快的 ChatGPT 用户)现在可以通过在“系统”消息中描述这些方向来规定他们的 AI 风格和任务,系统消息允许 API 用户在一定范围内显著自定义用户体验。OpenAI 将继续在这里进行改进(尤其要知道,系统消息是“越狱”当前模型的最简单方法,即,对边界的遵守不再那么死板),OpenAI 也非常鼓励让他们知道用户想要尝试这些 ideas。

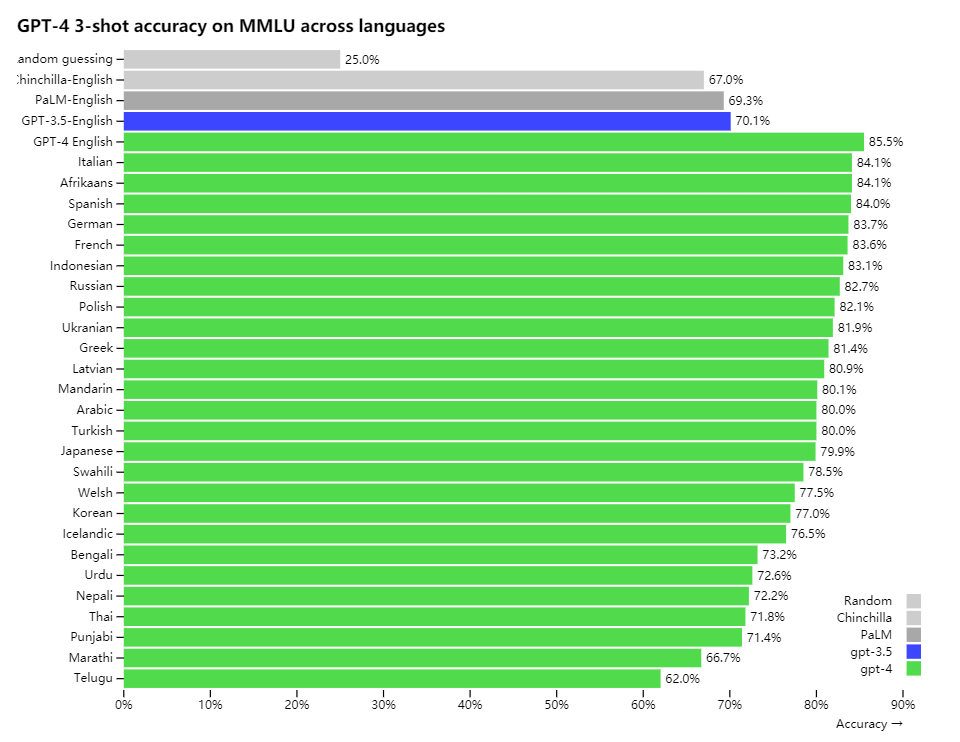

还有对多语种的支持能力也更强。测试的 26 种语言当中,有 24 种要比 GPT3.5 和其他的语言模型的精确度都要强。

小编瞪大眼睛瞅来瞅去,也没有看见中文。果断就去找了相关中文测试的效果究竟如何,结果呵呵了。不仅速度慢,一样也是给出了错误的答案!

ChatGPT 有没有比 GPT4 领先的地方?

有!那就是生成文本的速度,GPT4 生成答案的速度明显慢于 ChatGPT。看来能力越强,回答问题就会越慎重!

实际测评

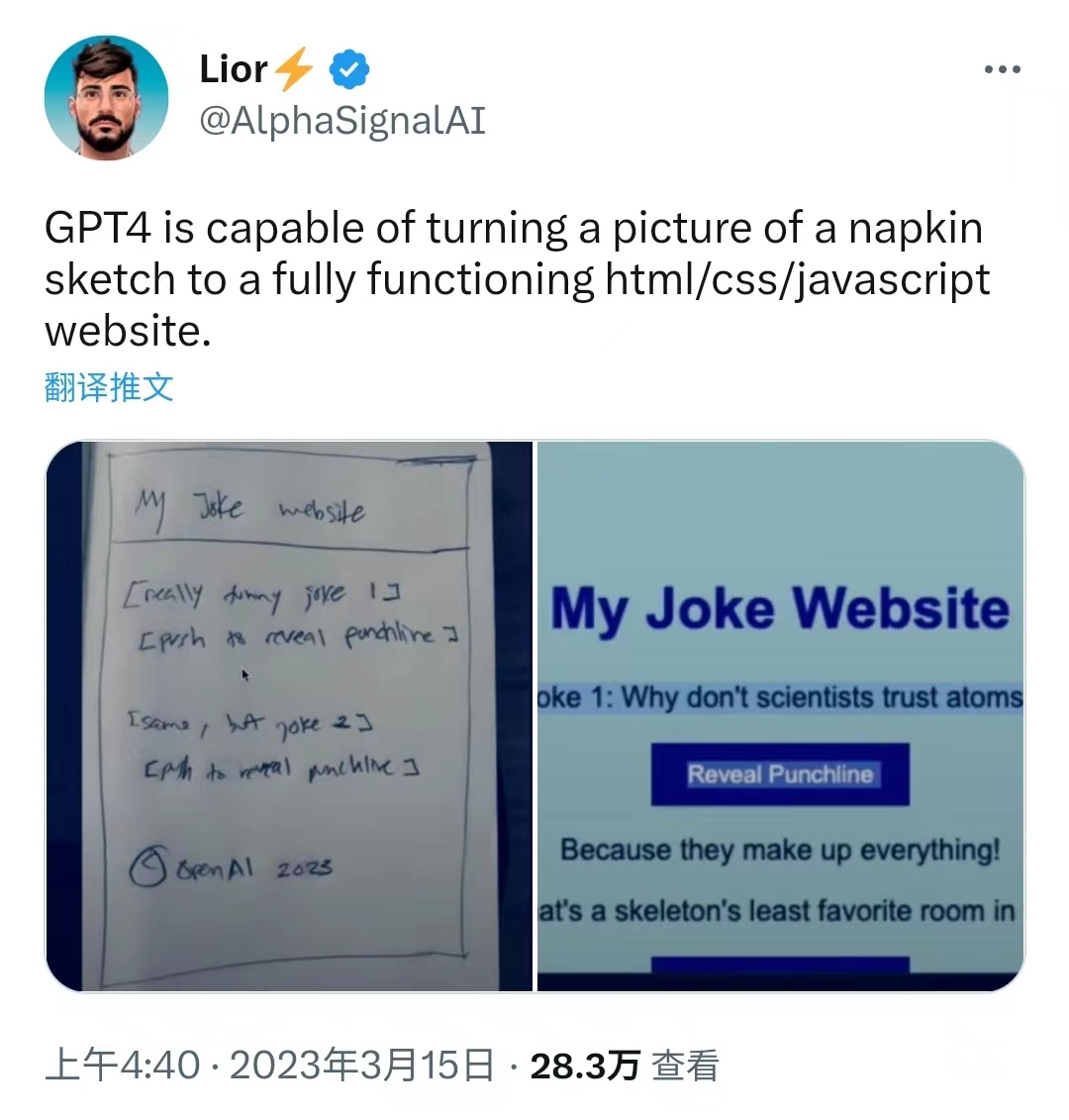

第一个例子是:餐巾纸上的草图都能让 GPT4 魔法一样生成个网页图!

图源:推特

真实例子,推特上一位用户将一张餐巾纸上的草纸图拍完照后,交给 GPT4,结果真的变成一张功能齐全的 html/css/JavaScript 网站。

网友惊呼:这模型竟然能够阅读和解释餐巾纸上写的任何内容!

还有位网友脑洞大开:那是不是基于 GPT4 的应用程序,将我的书面处方变成药剂师可以实际阅读的东西,就可以成为下一个美国生物技术亿万富翁。

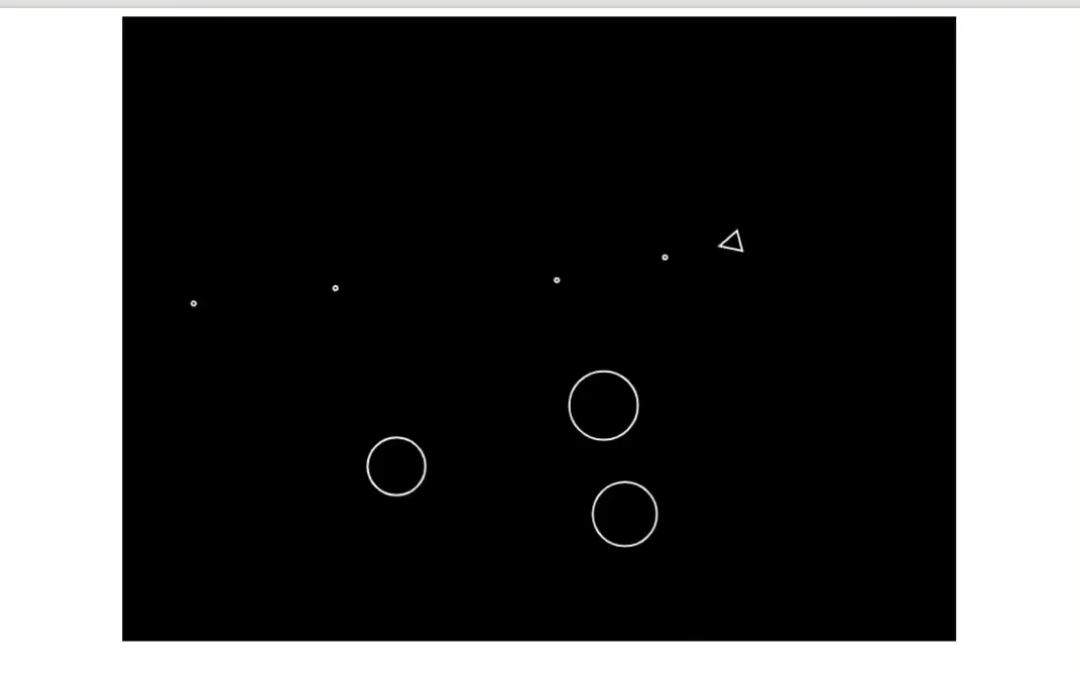

第二个例子:用 GPT4 重建游戏。

一位叫 Pietro 的用户在 60s 内重建了 Pong 游戏,而且分数还不错。

图源:推特

图源:推特

GPT4 由于其广泛的通用知识和解决问题的能力,可以更准确地解决难题。GPT4 的创造性恐怖如斯。

GPT4 的局限性

GPT4 虽然能力比 ChatGPT 更强,但局限性依旧与早期 GPT 模型相似。最重要的是,它仍然不完全可靠(它依旧会编造事实,并会犯推理错误)。在使用语言模型输出时,尤其是在高风险上下文中,应非常小心,使用与特定用例需求匹配的精确协议(如人工审查、附加上下文基础或完全避免高风险使用)。

在 OpenAI 的内部对抗性真实性评估中,GPT4 的得分比我们最新的 GPT3.5 高 40%。也就是说,即便 GPT4 生成的答案更准确,但也只是比 GPT4 更加可信了 40% 而已!

访问权限

ChatGPT Plus 用户可以从 chat.openai.com 上获得 GPT4 访问权限。同时,OpenAI 将根据实际需求和系统性能调整确切的使用上限,但 OpenAI 预计会产生严重的容量限制(尽管 OpenAI 将在未来几个月内进行扩展和优化)。

根据 OpenAI 看到的流量模式,OpenAI 可能会为更高容量的 GPT4 使用量引入新的订阅级别;OpenAI 还希望在某个时候提供一些免费的 GPT4 查询,这样那些没有订阅的用户也可以尝试。

要访问 GPT-4 API(它使用与 GPT-3.5-turbo 相同的 ChatCompletions API),还需要注册 OpenAI 的等待名单。

OpenAI 从今天开始,将邀请一些开发商,并逐步扩大规模,以平衡容量和需求。如果是有社会影响的研究人员,也可以通过 OpenAI 的研究人员准入计划申请使用。

应用生态已有探索

OpenAI 在内部使用 GPT4,对支持、销售、内容管理和编程等功能产生了巨大影响。OpenAI 还使用它来帮助人类评估人工智能输出,开始 OpenAI 对齐策略的第二阶段。

OpenAI 期待 GPT4 通过为许多应用程序提供动力,成为改善人们生活的宝贵工具。还有很多工作要做,OpenAI 期待着通过社区建设的集体努力来改进这一模式,探索并为这一模式做出贡献。小编注意到 OpenAI 已经和一家虚拟志愿者工具的公司达成合作。

Be My Eyes 的合作伙伴。通过世界各地的事实视频将需要视力支持的人与志愿者和住院者和公司联系起来。

简化低视力人群的任务

借助 Be My Eyes 应用程序,可以支持视障人群并帮助他们实现独立。盲人或低视力用户可能需要的支持包括:检查有效期、区分颜色、阅读说明或在新环境中导航。

写在最后

OpenAI 称 GPT4 是努力扩展深度学习的最新里程碑。GPT4 作为一个大型多模态模型(接受图像和文本输入,发出文本输出),在各种专业和学术基准上表现出人类水平的表现。

虽然跟我们之前做出的多模态能力预测(文本、图像、音频、视频等输入)有较大的差距,但可以看出 GPT 模型的演进正在扎实推进,尤其是通用知识的理解能力和更难问题的处理上,着实惊艳到了!

扫码关注公众号

获取更多技术资讯