Nano Banana有点ChatGPT时刻的味儿了

HelloKitty • 2025-09-08 15:09

2642

本文由 硅星人Pro 撰写/授权提供,转载请注明原出处。

以下文章来源于:硅星人Pro

作者:周一笑

你可以不关心香蕉的价格,但很难忽视 Nano Banana 这根香蕉。

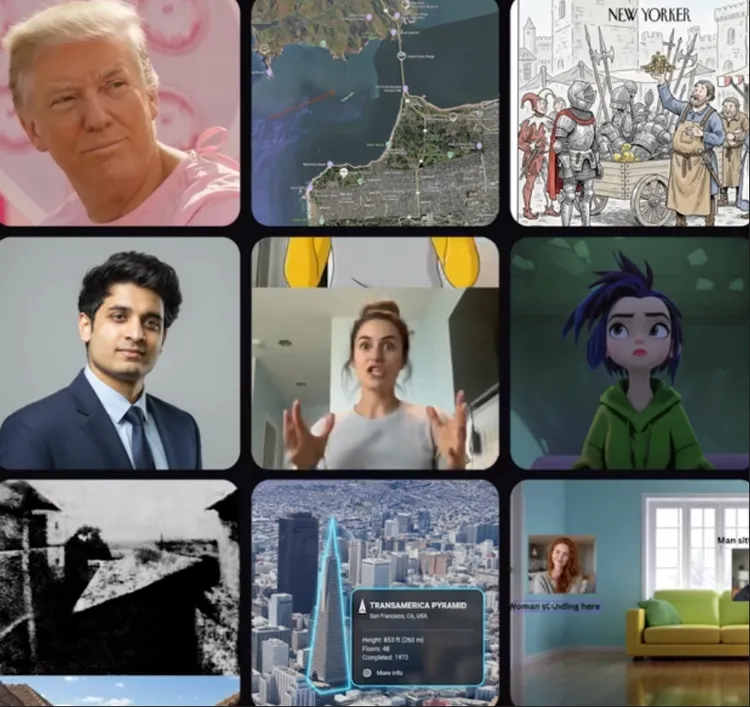

在社交媒体和技术社区,用户正热衷于分享它的各种玩法,有人用它把桌面手办转换成真人 Cosplay,有人上传多张素材图,生成风格统一的合成画,还有人把孩子随手画的火柴人一键升格成电影级动态分镜。

Nano Banana 的快速响应和自然度,让创作更像实时对话,而不是反复抽卡。这也是许多人第一次感到,AI 图像生成变得像实时创作。用户不再需要反复调试结构化的咒语,而是通过简单的自然语言对话,就能对图像进行精确修改 。

再加上几秒内生成的速度,整个过程的流畅感是前所未有的 。这也直接带动了 Gemini App 的用户增长,在短时间内,Nano Banana 为 Gemini App 带来了超过 1000 万新用户。

它的走红,甚至让一些人联想起了 ChatGPT 的发布时刻,人们经久不息的从各个角度讨论它、使用它、甚至是捕风捉影猜测它背后的技术实现,而 Nano Banana 的确给用户带来了类似 ChatGPT 初期的惊艳感,让大量非技术用户第一次体验 AI 能力的进化,到高质量、实时、交互式的图像生成/编辑。

Nano Banana 究竟做对了什么?

Nano Banana 的好用,不是单一能力的提升,而是它从根本上改善了 AI 图像创作的流程。

过去,用户需要学习结构化的提示词才能获取较好的效果。现在,这个过程变成了一场流畅的对话,发出“给这个人戴上眼镜”或“把背景换成阴天”这样的指令,对画面进行精确的局部修改 ,Nano Banana 能记住你们的对话,进行相应的响应。

这种记忆力也体现在角色一致性上。以往需要 LoRA 或 Dreambooth 等复杂微调技术才能实现的人物固定,现在用户只需用一张图定下角色,就能在后续的对话中,让同一个人出现在不同场景、摆出不同姿势 。在“长得像本人”这个核心需求上,Nano Banana 已经与其他模型拉开了代差。

它还能将多张输入图像无缝融合成一个连贯的画面,把一张图里的物体自然地放进另一张图的场景里 。更深一层,与许多基于美学训练的模型不同,Nano Banana 背后整合了 Gemini 家族的世界知识与推理能力 。这让它在执行指令时更聪明,比如能理解现实世界的概念,为你画的特定场景选择恰当的植物物种 。

让这一切体验真正落地的,是速度。数秒的响应时间,带来的不仅是效率,它鼓励用户快速尝试、快速失败、快速调整,用不断的试错来探索创意,而非追求一次成功。其团队成员将这种迭代的过程,称为真正的魔力所在 。

在团队的访谈和公开分享里,Nano Banana 的几个方向被反复提及:文字渲染、交错生成、速度哲学,以及世界知识的引入。这些关键词,勾勒出了它的不同之处。

在很多人的直觉里,文字渲染是附属能力,能不能把广告牌上的字写对,好像无伤大雅。但对 Nano Banana 团队而言,这却是衡量整体性能的核心指标 。文字是一种高度结构化的视觉信息,一个笔画的细微偏差都会让人立刻识别出错误 。

当模型能正确渲染文字时,它也学会了如何在像素层面把控结构和细节,这一能力迁移到其他任务时,会带来整体质量的提升 。团队后来把文字渲染当作一种“代理指标”(Proxy metric),成为持续优化的抓手。

一些 LLM 从业者尤其表达了把文字渲染作为“代理指标”的带来的启发:找到合适的代理指标,能够成为牵动整体性能提升的杠杆。选择一个对精确度要求极高的任务,通过优化它来驱动整体能力提升。当模型要对齐到一个极端精细、结构化、容错率极低的子任务时,它被迫学会的底层能力,往往会溢出到更宽泛的任务里。

如果说文字渲染解决了画得对的问题,那么交错生成(Interleaved Generation)则改变了“怎么画”的过程。过去的图像生成更像是抽卡,彼此之间没有上下文联系 。Nano Banana 引入的交错生成机制改变了这一点 。模型在同一个上下文里生成多张图,第二张能记住第一张,第三张能记住前两张 。这种串行方式让创作更像一个过程,上下文的连贯性,带来了比以往稳定得多的体验。

而要让这个充满过程感的创作体验不被割裂,速度是关键。在图像编辑中,完美几乎是不可能的。Nano Banana 团队的共识是,与其追求一次性满足所有细节,不如强调速度 。因为只要生成足够快,用户完全可以毫无心理负担地快速迭代 。

除了流程上的革新,模型在内容理解的深度上也与过去不同。另一个被反复强调的点,是它在生成过程中引入了世界知识 。这使得它不仅能画出视觉上漂亮的图像,还能处理带有常识和背景要求的复杂指令 。例如,在一个 80 年代美国购物中心风格的场景里,模型不仅理解购物中心,还能在细节上符合那个年代的服饰、灯光和空间语法 。

这种能力的实现,也源于团队的融合。一方面,Gemini 团队在推理、世界知识和上下文理解上的优势,为模型奠定了基础 。生成与理解并不是割裂的,团队在访谈中多次强调,图像理解和图像生成像“姐妹能力”,提升一端往往会推动另一端。

另一方面,Imagen 团队在图像美学和自然度上的经验,帮助模型解决了“看上去是否真实、是否优雅”的问题 。二者结合,使得 Nano Banana 在一致性和美感之间找到了平衡。

Nano Banana 团队也透露了未来的方向,他们追求的并不只是视觉质量的提升,而是让模型更聪明(smart) ,就是指当用户给出一个模糊或不完整的指令时,模型能够理解意图,甚至在结果上超越原始的要求 。团队成员Mostafa形容这种体验是,“我很高兴它没有完全听我的” 这有点类似模型不再只是被动执行,而是具备了一定的审美判断和创造力的 Agent。

一些猜想

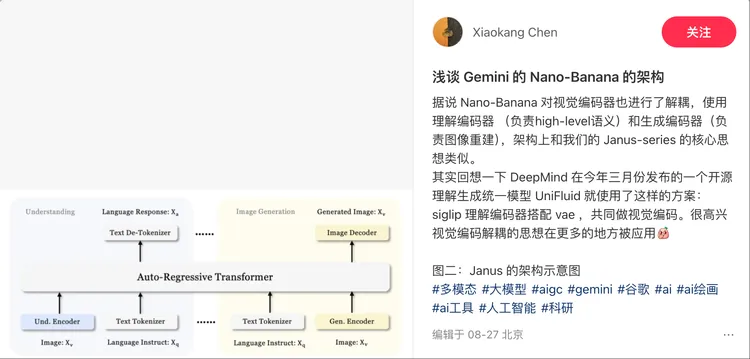

对于 Nano Banana 的底层架构,官方几乎没透露什么信息 。这种"黑箱"状态,也激发了技术社区讨论和推测。

一种观点认为,它可能沿用了 MMDiT(多模态扩散 Transformer)的路线 。这种设计通过统一的 Transformer 架构处理文本和图像,将不同模态的信息编码到同一个表示空间里,以实现更原生的跨模态生成 。

也有分析认为模型上层可能有 Gemini 2.5 这样的大语言模型负责语义理解和推理,而下层则连接一个专门优化过的扩散模型,用于完成高质量的图像输出,以此结合两者的优势 。

此外,一位个人简介为 DeepSeek AI 研究员的小红书用户认为其设计思路更接近 Janus 或 UniFluid 的统一路线 。即在同一个 Transformer 主干上,同时接入负责理解的编码器和负责生成的解码器,从而高效地实现看图理解和文本出图的双向能力。

Nano Banana 时刻?

ChatGPT 时刻的核心,在于技术飞跃带来了零门槛的体验,并迅速转化为大众价值。Nano Banana 在很大程度上复刻了这一点。

但局限同样存在。模型卡片已经明确指出,Gemini 2.5 Flash Image 在长文本渲染和复杂细节的事实性呈现上仍有不足,作为 Gemini 2.5 Flash 的附加能力,它也继承了基础模型的普遍限制。所谓原生多模态,依旧偏向图像任务优化,而 Google 在底层实现上的克制披露,也让外界难以全面判断它的真正突破。

即便如此,Nano Banana 已经证明,图像生成正走向一个全新的阶段。Nano Banana 已经来了,Giant Banana 还会远吗?

扫码关注公众号

获取更多技术资讯