OpenAI推出“小”模型GPT-4o Mini,成本骤降,开始跟各位卷性价比了

HelloKitty • 2024-07-22 14:02

4125

本文由 硅星人Pro 撰写/授权提供,转载请注明原出处。

文章来源于:硅星人Pro

作者:Jessica

今天,OpenAI 忽然官宣推出全新小模型「GPT-4o Mini」,相当于旗舰模型 GPT-4o 的轻量经济版来供开发者使用。

此前,一些没有足够资金的开发者可能对 GPT 高昂的价格望而却步,转而选择更便宜的模型,例如谷歌的 Gemini 1.5 Flash 或 Anthropic 的 Claude 3 Haiku 来构建应用程序。而现在,OpenAI 也正式进入了轻量级模型的市场。

作为 OpenAI 最具成本效益的小模型, GPT-4o Mini 主打的就是便宜好用。价格为每百万输入 15 美分和每百万输出 60 美分(约等于一本 2500 页的书)。比以前的前沿模型便宜一个数量级,比 GPT-3.5 Turbo 便宜 60% 以上。

性能上它比 GPT-3.5 Turbo 更强大,在 MMLU 测试中得分 82%,并在 LMSYS 机器人竞技榜上打败了 GPT-4(0125 版本)。

以上低成本、低延迟的优点显著扩展了它基于 AI 的应用范围,为包括多 API 调用、大规模上下文处理、实时客户互动等多种任务提供了一个经济高效的解决方案。

目前 GPT-4o Mini 支持文本和视觉输入,未来将扩展至音视频。它拥有 128K 上下文窗口,每次请求最多可输出 16K 标记,知识库更新至 2023 年 10 月。而且由于与 GPT-4o 共享改进的分词器,使其处理非英语文本的成本效益更高。

“2022 年,当时世界上最好的模型是 text-davinci-003。它比这个新模型差得多,而它的成本高了 100 倍。” Sam Altman 说,“最重要的是,我们认为人们真的会非常喜欢使用这个新模型。”

一款具有卓越文本智能

和多模态推理能力的小模型

根据 OpenAI 官方介绍,GPT-4o mini 在学术测试中表现优异,超越了 GPT-3.5 Turbo 等小型模型。它在文本智能、多模态推理和语言支持方面水平与 GPT-4o 相当。在函数调用方面表现突出,有助于开发者创建能与外部系统交互的应用。此外还显著提升了长上下文处理能力,优于 GPT-3.5 Turbo。

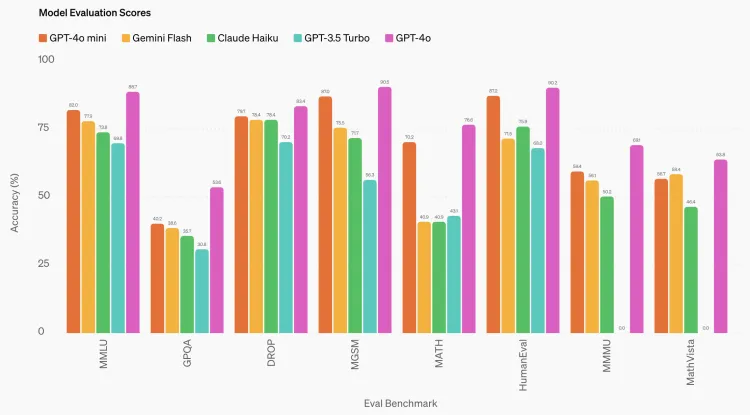

具体几项基准测试得分来看:

文本和视觉推理任务上,GPT-4o mini 在 MMLU 中得分为 82.0%,相比之下 Gemini Flash 得分为 77.9%,Claude Haiku 得分为 73.8%。

数学和编码能力方面,GPT-4o mini 也超过了市场上的所有轻量级小模型。在衡量数学推理的 MGSM 中,GPT-4o mini 得分为 87.0%, Gemini Flash 得分 75.5%,Claude Haiku 得分 71.7%。在编码性能测试 HumanEval 中,GPT-4o mini 拿下 87.2%,而 Gemini Flash 和 Claude Haiku 分别为 71.5% 和 75.9%。

来到多模态推理,GPT-4o mini 在 MMMU 中再次以 59.4% 分夺冠,其对手 Gemini Flash 得分 56.1%,Claude Haiku 得分 50.2%。

新模型何时、何处可用?

现在,GPT-4o mini 现已作为文本和视觉模型在 Assistants API、Chat Completions API 和 Batch API 中可用,并在未来几天内推出微调功能。如果开发者不想切换到 GPT-4o Mini ,仍可以通过 API 访问 GPT-3.5 Turbo。OpenAI 表示,GPT-3.5 将在某个时候从 API 中退役,但具体时间未定。

ChatGPT 的所有免费、Plus 和团队用户今天起就可以使用 GPT-4o mini 来取代 GPT-3.5,企业用户也将在下周开放。

对于渴望以低成本构建 AI 应用程序的开发者来说,GPT-4o Mini 的推出无疑为他们提供了另一个有力选择。OpenAI 已经让金融科技初创公司 Ramp 测试了该模型,使用 GPT-4o Mini 构建了一个从收据中提取费用数据的工具。电子邮件客户端 Superhuman 也参与了测试并用它创建了一个自动建议邮件回复功能。

可能是小模型界的新晋最强战将

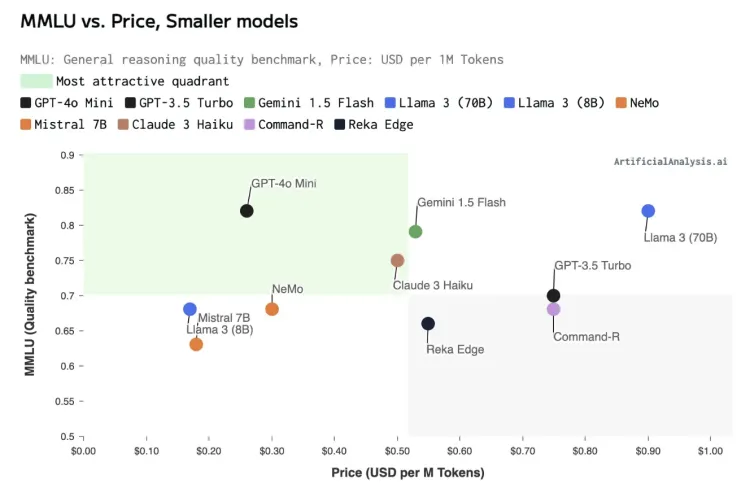

OpenAI 并没有透露GPT-4o mini 的具体大小,但表示它大致与其他小型 AI 模型(如 Llama 3 8b、Claude Haiku 和 Gemini 1.5 Flash)处于同一水平。OpenAI还称GPT-4o mini 在速度、成本效益和智能上都全面碾压行业领先的小模型。这也在 LMSYS.org 聊天机器人竞技场的预发布测试中得到了验证。

GPT-4o mini 与其它小模型在性能与成本上的综合比较。图源:Artificial Analysis

“与同级别模型相比,GPT-4o mini 的输出速度非常快,中位输出速度为每秒 202 个标记,”Artificial Analysis 联合创始人 George Cameron 表示,“这比 GPT-4o 和 GPT-3.5 Turbo 快 2 倍多,是许多依赖速度用例的极佳选择。”

Sam Altman 在推文里说,GPT-4o mini 是朝着让“智能便宜到无法测量”努力的重要一步。

而关于 OpenAI 为何花了这么长时间才推出轻量模型,产品主管 Olivier Godement 表示,这是“纯粹的优先级”问题。因为公司专注于创建 GPT-4 这类更大更好的模型,这需要大量“人力和算力”。随着时间的推移,OpenAI 注意到开发者急于使用较小的模型,因此决定现在是时候将资源投入到构建 GPT-4o Mini 上。

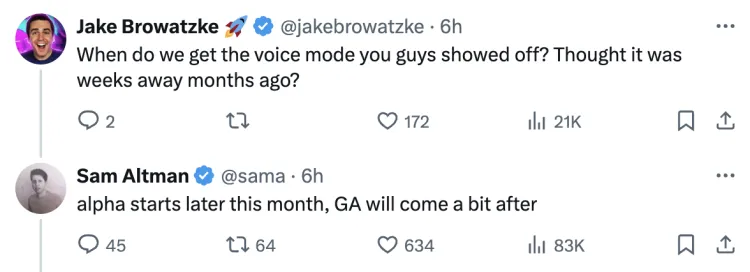

对于网友最关心的“什么时候才能开放语音模式”的问题,Sam Altman 也给出了回复:“7 月晚些时候推出测试版,公众访问权限更晚些开放。

回到 OpenAI 这第一款小参数轻量模型 GPT-4o Mini 。Godement 认为, GPT-4o Mini 真正体现了 OpenAI 让 AI 技术更广泛可及的使命。“如果我们希望 AI 能惠及世界的每一个角落、每一个行业、每一个应用,我们就必须让 AI 更加经济实惠。”

而除了达成惠及全球各地开发者和用户的目标,让 AI 不仅是大公司的专利,从企业运营角度来说,进军小模型领域更能扩大 OpenAI 产品的覆盖范围,在市场竞争中保持优势。

此举也无疑会给 Google、Anthropic 等其他竞争者带来压力,发现自己好不容易站稳的地盘又引来了 OpenAI 这个业内王者入局。但对于普通用户来说,这并非一件坏事。也许会刺激整个行业在小型高效模型方面的研发和创新,让 AI 技术更加普及易用,从而丰富整个生态系统。

扫码关注公众号

获取更多技术资讯