Pieter Abbeel 新工作“大世界模型”:轻松玩转 1 小时长视频,一对一 QA 视频内容细节

HelloKitty • 2024-02-20 17:03

3215

本文由 AI科技评论 撰写/授权提供,转载请注明原出处。

文章来源于:AI科技评论

作者:赖文昕

编辑:陈彩娴

自 3 天前 Sora 发布以来,由图灵奖得主、Meta 首席科学家 Yann LeCun 提出的“世界模型”又一次引起了广泛关注。

“世界模型”作为 Sora 的一大核心亮点,被 OpenAI 写在技术报告中。但 Sora 是否真的如 OpenAI 所说,是一个世界模型,却引起了行业内的争论。

在 Yann LeCun 的愿景中,世界模型是一个能够学习世界如何运作的内在规律的内部模型,可以更快速地学习,为完成复杂任务做出计划,并且随时应对不熟悉的新情况,所以它很有可能克服目前限制最先进的 AI 系统发展的难关。

而在这场争论持续之际, UC Berkeley(加州大学伯克利分校)发布了一项名为“Large World Model(LWM)”的最新研究成果,今日已成功登上 GitHub 榜首。

值得一提的是,两位华人学者 Hao Liu 和 Wilson Yan 为共同一作,指导老师是吴恩达开门大弟子、伯克利人工智能实验室主任 Pieter Abbeel 与计算机副教授 Matei Zaharia。两位教授的谷歌学术引用次数均十分耀眼,分别高达 13.8 万次与 7.4 万次。

论文链接:https://arxiv.org/pdf/2402.08268.pdf

为了应对由于内存限制、计算复杂性和数据集有等重大挑战,这个团队构建了一个由不同视频和书籍组成的大型数据集,以 Hao Liu 先前提出的 RingAttention 技术为基础,对长序列进行可伸缩训练,并将上下文大小从 4K 逐渐增加到 100 万 tokens,一次可以分析 1 小时长度的视频。

100 万 token,1 小时长视频它还开源

大模型的发展进程快得令人惊叹,但是仍存在不少技术痛点。比如,目前的语言模型无法理解世界上某些难以用语言描述的问题,且难以处理复杂冗长的任务。

针对这个难题,该团队提出了“Large World Model(LWM)”,因为视频序列能提供语言和静态图像中没有的、有价值的时间信息,这使得它们对于语言的联合建模具有特别作用。这样的模型可以更好地理解人类文本知识和物理世界,从而实现更广泛的人工智能能力来帮助人类。

这个“大世界模型”是否确如其名呢?

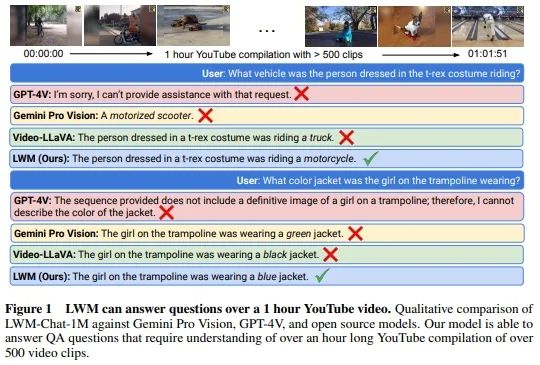

在研究报告的开篇,团队便自信展示了 LWM 与 GPT-4V、Gemini Pro Vision 与 Video-LLaVA 的对比结果:将长达 1 小时的油管视频输入并根据视频内容细节提问后,只有 LWM 能提供准确的答复。

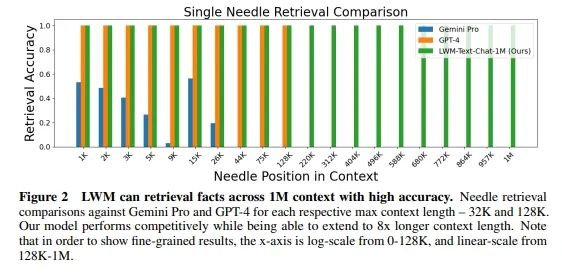

而除了能读懂理解长视频外,LWM 在超长文本任务的表现同样亮眼。LWM 可以高精度地检索 1M 上下文中的事实。针对 Gemini Pro 和 GPT-4 各自的最大上下文长度(32K 和 128K)进行单针检索比较时,LWM 在各个指标上的表现均大幅领先。

团队对 LWM 的研究成果作出了以下总结:

. 该研究在长视频和语言序列上训练了一个拥有极大上下文尺寸的 transformers 模型,从而设立了新的检索任务和长视频理解方面的标杆。

. 为了克服视觉 - 语言训练带来的挑战,该研究采取了以下措施,包括使用掩码序列以混合不同长度的序列、损失加权以平衡语言和视觉、以及使用模型生成的问答数据来处理长序列对话。

. 通过 RingAttention、掩码序列打包等方法,可以训练数百万长度的多模态序列。

. 完全开源 7B 参数系列模型,其能够处理超过 100 万 token 的长文本文档(LWM-Text、LWM-Text-Chat)和视频(LWM、LWM-Chat)。

分阶段的渐进式训练模型能力逐步升级

是什么训练方法让 LWM 具备如此亮眼的能力呢?

LWM 的训练步骤主要分为两个阶段:第一阶段是学习长上下文语言模型(Learning Long-Context Language Models),第二阶段是学习长上下文视觉-语言模型(Learning Long-Context Vision-Language Models)。

第一阶段时,团队将研究重点分为了上下文扩展、训练步骤、聊天微调和语言结果评估四个部分。

在上下文扩展中,他们使用 RingAttention 技术,通过分块计算和序列并行,理论上可以扩展到无限上下文,仅受限于可用设备数量。

RingAttention 作为一个环形结构来组织 blocks,这样每个 block 只需要与其相邻的 block 进行通信、交换信息,此结构能够大大减少通信开销。

分块计算则是将长序列分割成多个较小的 blocks,每个 block 包含固定数量的 tokens。这样,模型只需要计算每个 block 内的注意力权重,而不是整个序列。

在训练过程中,序列并行的方法可以并行处理多个 block,每个 block 由不同的 GPU 处理,使模型能在多个设备上同时处理序列的不同部分,从而提高了训练效率。

同时,由于 RingAttention 支持渐进式训练,让模型可以从处理较短的序列开始,然后逐步增加序列长度。于是团队就采用了渐进式训练方法,从 32K tokens 开始,逐步增加到 1M tokens,以有效扩展上下文大小。这意味着此方法有助于模型逐步学习处理更长序列的能力,同时保持训练效率。

到了训练步骤的部分,团队会初始化模型参数,然后逐步增加上下文长度,分为 32K、128K、256K、512K 和 1M tokens 共 5 个阶段,且在每个阶段,会使用不同版本的 Books3 数据集进行训练,这些数据集经过过滤,以适应当前的上下文长度。

针对聊天微调,团队构建了模型生成的问答数据集,通过将文档分割成固定大小的 block,然后使用短上下文语言模型生成问题和答案对。而在长上下文长度(如 32K tokens)下,则是通过连接相邻的 block 和在序列末尾添加相关的问答对来构建单个 32K tokens 的示例。

在第一阶段的最后,团队对于 LWM 的语言能力进行了单针检索、多针检索、多文本评估和聊天评估。

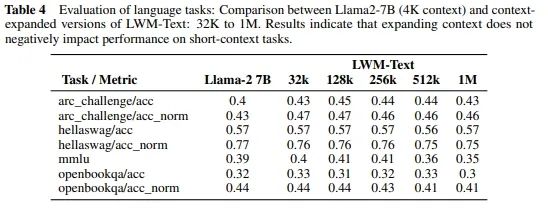

值得一提的是,此研究还对比了具有 4K 上下文的 Llama2-7B 模型与 LWM-Text(从 32K 到 1M)的语言能力。评估涵盖了各种语言任务,证明扩大上下文大小不会影响短上下文任务的性能。结果表明,LWM 在 32K 到 1M 长度下各任务中表现得同样好,甚至更好。

这一证据表明上下文扩展不存在负面影响,突显了模型适应不同任务要求而不会在较短上下文中损失效率的能力。

在完成语言模型的训练后,团队开启了他们的第二阶段——学习长上下文视觉-语言模型。在此阶段中,团队也将研究工作分为三个板块,即视觉架构修改、训练步骤和评估结果。

对于视觉架构修改,他们使用了预训练的 VQGAN 将图像和视频帧转换为离散 tokens,并且引入新的 tokens 来区分文本生成的结束和视觉生成的开始,以及视频帧的结束。

而在训练步骤中,团队从 LWM-Text-1M 文本模型开始初始化,然后在大量结合文本-图像和文本-视频数据上进行渐进式训练。他们分别在 1K、8K、32K、128K 和 1M tokens 的序列长度上进行训练,同样地,每个阶段都是从先前的较短序列长度阶段初始化。

在最终的评估结果上,团队在长视频理解、图像理解和短视频理解等任务上评估了 LWM 的模型性能并展示了其在处理长视频和图像生成方面的优秀能力。

结语

Sora 在 2024 年拉响了大模型比拼的第一枪,使得文生视频技术跃为时下焦点,也让“世界模型”变得似乎不再遥不可及。

在应对长文本、视频甚至是多模态技术时,世界模型对物理世界规律的理解与应用,或将成为各家大模型选手能否在角逐中取胜的关键。

扫码关注公众号

获取更多技术资讯