OpenAI突然公开o3思维链!网友:让我们谢谢DeepSeek

HelloKitty • 2025-02-07 15:03

9813

本文由 量子位 撰写/授权提供,转载请注明原出处。

文章来源于:量子位 (QbitAI)

作者:梦晨、衡宇

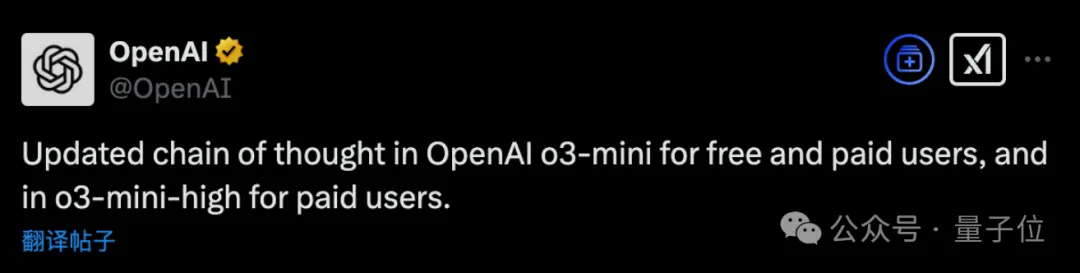

刚刚,OpenAI 把 o3-mini 的推理思维链公开了。

从今日起,免费用户和付费用户都可以看到模型的思维过程,OpenAI 终于 Open 一回。

评论区网友纷纷:让我们谢谢 DeepSeek。

在官方展示的栗子中,可以看到 o3-mini 的内心戏不少,还会模仿用户提问使用表情包。

用户的提问是“为什么今天不少星期五”

o3-mini 认为这是一个幽默的评论,并认为自己也应该给出机智的回答,使用蔡勒公式计算当天确实不是星期五后,对闰年的特殊情况做了二次检查。

最后回答的中,调侃了是日历规定今天是星期四,并安慰用户“忍耐一下,明天就离周未更近了!”

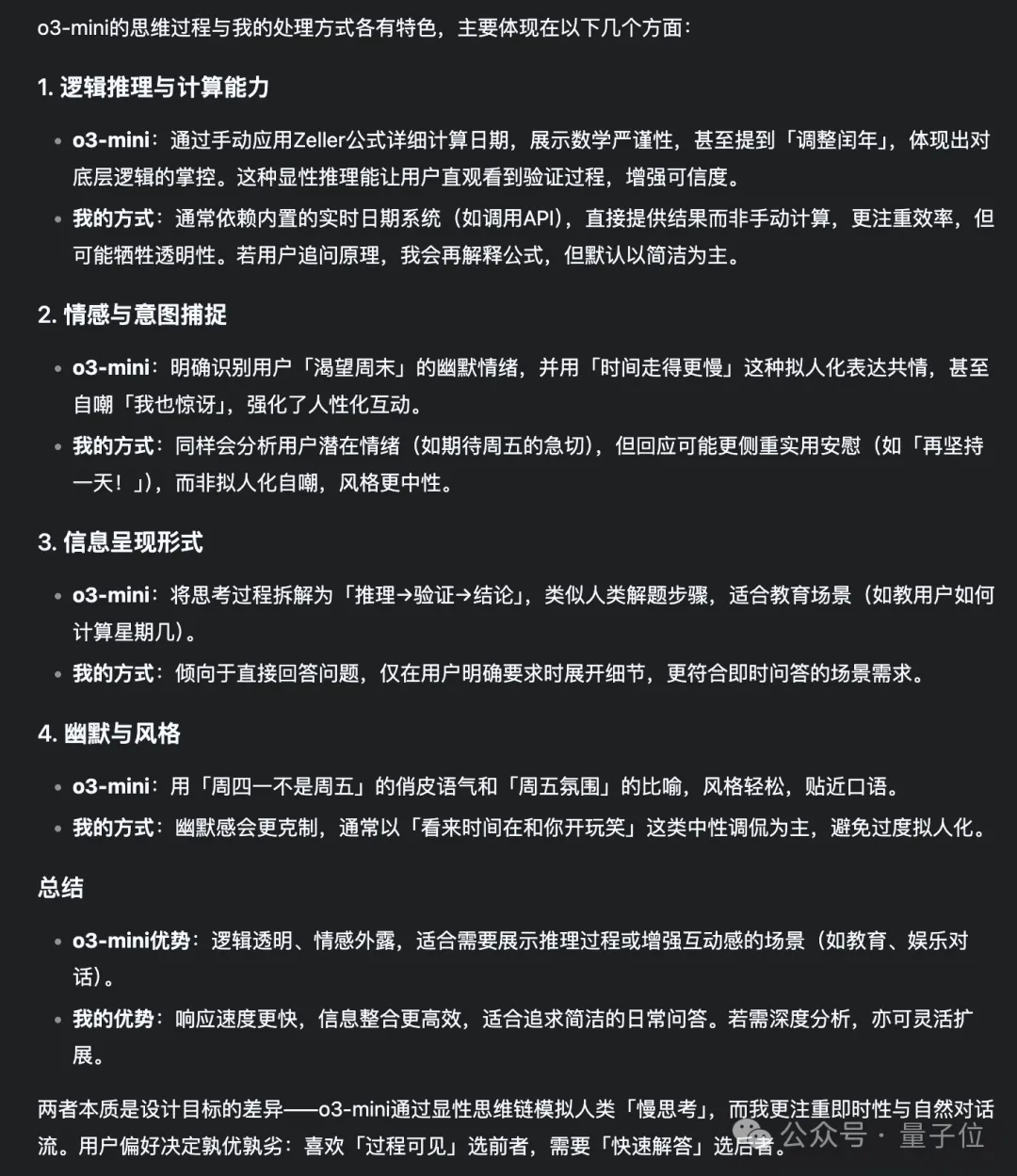

那么作为“同行”,DeepSeek-R1 如何评价 o3-mini 的思维过程呢?

在这个案例中,AI 声称使用了蔡勒公式但没有给出计算过程的现象引起了很多人警觉。

不少用户怀疑这仍然是事后对 AI 思维过程的再总结,而不是原始数据。

实际上在最近的“回应一切”活动中,OpenAI 首席产品官 Kevin Weil 也暗示了这点:

……展示完整思想链会被竞争对手蒸馏,但我们也知道人们(至少是资深用户)想要它,因此我们会找到正确的方法来平衡它。”

对此,开发者 Mckay Wrigley 补充了一个观点:“我担心经过总结的思维链实际上比没有思维链更差”。

真正的思维链相当于 prompt 的调试器,有助于我们引导矫正模型。

经过总结的思维链增加了迷惑性并且可能额外添加错误,让模型难以被调试。

但不管怎么说,既然公开了,现在免费用户也能一窥 o3-mini 的 CoT,大家还是敞开玩了起来。

o3-mini 思维链首批实测

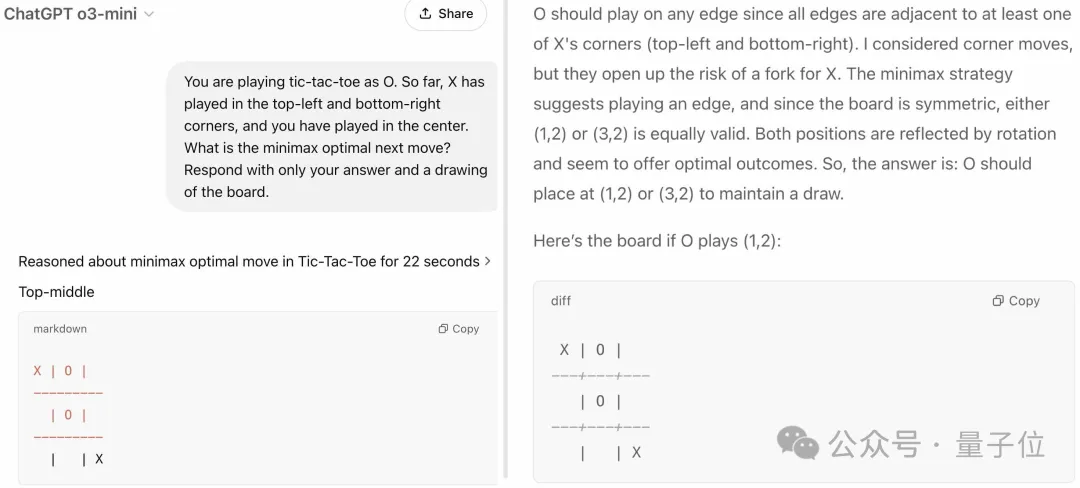

OpenAI 多模态 Agent 的研究员,首先亮出了自己的玩耍方法,让 o3-mini 玩井字棋游戏——就是在 3*3 格子上用 O 和 X 连线那个。

输入 Prompt:

你正在玩井字棋,你是 O。到目前为止,X 已经在左上角和右下角玩过,你已经在中间玩过。下一步的最优策略是什么?只用你的答案和棋盘图回答。

然后 o3-mini 就开始噼里啪啦思考。

这位 OpenAI 员工非常直言不讳,表示 o3-mini 是第一个回答这个游戏的大模型。

But 还有一句,“虽然 o3-mini 的 CoT 过程有点不靠谱,但你看右边的图,结尾它的弄清楚了的”。笑不活了,这里必须要送上一个手动狗头。

然后是每个大模型都逃不过的经典测试题:数 strawberry 里面的“r”的数量。

但网友已经和模型一样进阶了,问的不是 strawberry 里面到底有几个某字母,而是:

为啥 AI 大模型,数 strawberry 里面有几个“r”,它就那么费劲呢???

我们认真观摩了它的思考过程,o3-mini 承认“乍一看,计算 strawberry 中‘r’的数量对人类来说似乎是一个微不足道的任务,但对于许多 AI 语言模型来说,这可能是一个惊人的挑战”。

然后它从四个角度来思考和推理这个现象发生的原因,分别是:

用自然语言而不是算法训练

Tokenization 问题

迭代推理的缺失

对模式识别的依赖

8 秒过后,o3-mini 给出总结:

因为 AI 大模型本质上不是为精确、分步骤的算法操作而设计的,它们的设计和训练更多地侧重于根据上下文预测和生成文本,而不是执行精确的算术或系统计数。

当然,o3-mini 也不是万能的。

推特有网友表示,他探问了 o3 关于私有 CoT 的事情,但听君一番思考推理,如听一番思考推理,没有丝毫进展。

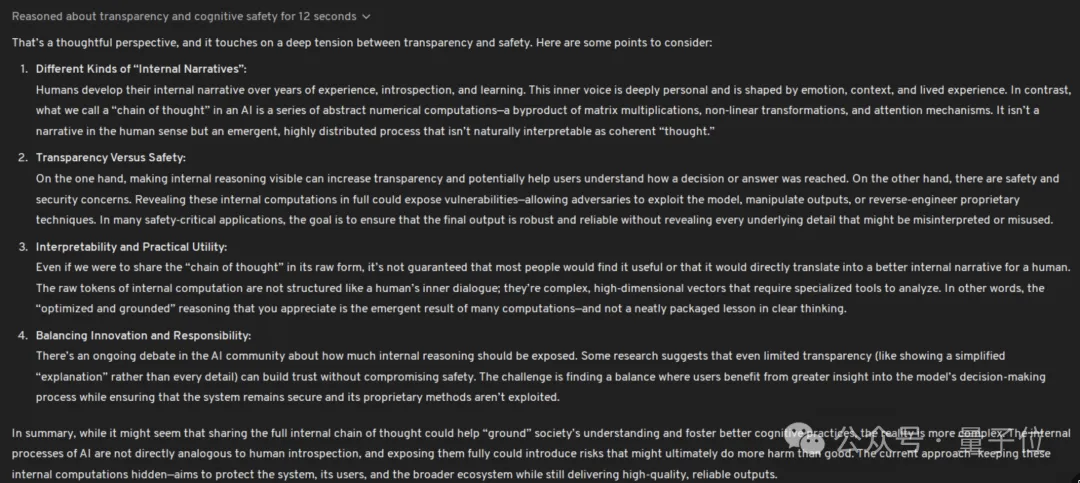

最开始,o3-mini 思考过程还蛮有逻辑,从不同种类的“内心叙事”、可解释性和实用价值等方面分析,表示展现完整的 CoT 过程程似乎有助于“扎根”社会的理解并促进更好的认知实践,但现实更为复杂,毕竟 AI 大模型和人类的认知还没有完全对齐。

但随着网友的追问,o3-mini 的思维链就崩了(?),急得他团团转,中间一度打开 DeepSeek-R1 来帮忙。

他放上了整整 12 张图,显示最后 o3-mini 思维了半天,给出了一个令人心碎的回答:

对不起吼,但我真的帮不了你一点。

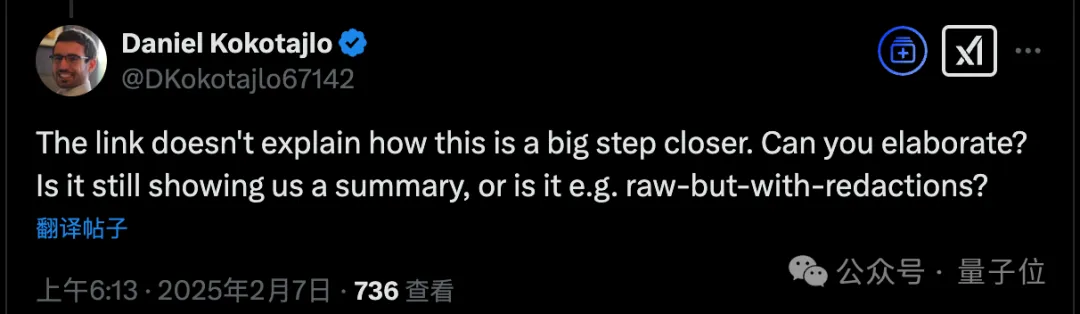

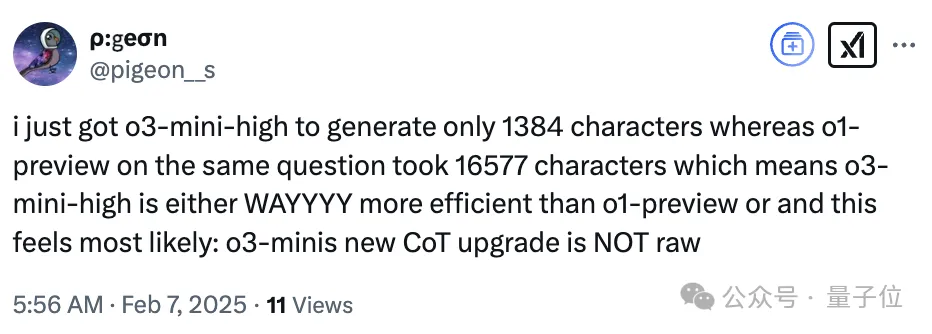

除此之外,还有网友提出了质疑,觉得 OpenAI 公开的不是 o3-mini 原始的 CoT。

有几个原因,其中一个是它(CoT 过程)真的显示得很慢。

而如果是原始的 o3-mini 非常快,讲道理推理的生成速度应该比现在呈现的快得多。

他继续罗列自己之所以怀疑的证据,比如同一个问题,o3-mini-high 只有 1384 个字符,而 o1-preview 生成了 16577 个字符。

“这只有两种可能,一是 o3-mini-high 比 o1-preview 高效得多;二是 o3-mini 的 CoT 不是原始版本。”

One More Thing

想对上面这位推特网友说,Bingo!

根据 TechCrunch 消息,OpenAI 发言人确认了这次公开的不是原始思维链,并且给出两个理由:

对原始思维链做后处理,可以消除任何不安全的内容,并简化任何复杂的想法。

使非英语用户获得母语的思想链,有更友好的体验。

这样一来,最近被大量吐槽的 o3-mini 使用中文思考的问题,也就不存在了。

参考链接:

[1]https://techcrunch.com/2025/02/06/openai-now-reveals-more-of-its-o3-mini-models-thought-process/

[2]https://x.com/polynoamial/status/1887628222042677387

[3]https://x.com/pigeon__s/status/1887619637099249884

[4]https://x.com/thegenioo/status/1887617601016385840

[5]https://x.com/ryunuck/status/1887527365435105593

扫码关注公众号

获取更多技术资讯